Chapter 6 Machine learning

A key aspect of machine learning is cross validation to evaluate the model. It repeatedly evaluate the model based on different subsets of the model and using different parameters to select the optimal parameters. The models are compared against subset of the data. The caret library is an excellent tool for performing model selection.

6.1 Decision tree analysis

Decision tree method generates a logical flow diagram that resembles a tree. This triangulated diagram, with repeated partitioning of the original data into smaller groups (nodes) on a yes or no basis, resembles clinical reasoning. By way of contrast, regression methods generate significant predictors but it’s not clear how those predictors enter the sequential nature of clinical reasoning. Regression models assume that all of the variables are required at once to formulate an accurate prediction. This would make some of the elements of any model from regression analysis superfluous.

There are several different approaches to performing decision tree analyses. The most famous method CART is implemented in R as rpart. The second approaches uses chi-square test to partition the tree, available from the party library. Decision tree may also reveal complex intreactions (relationship) among the predictors in a way that regression analyses do not easily reveal.

6.1.1 Information theory driven

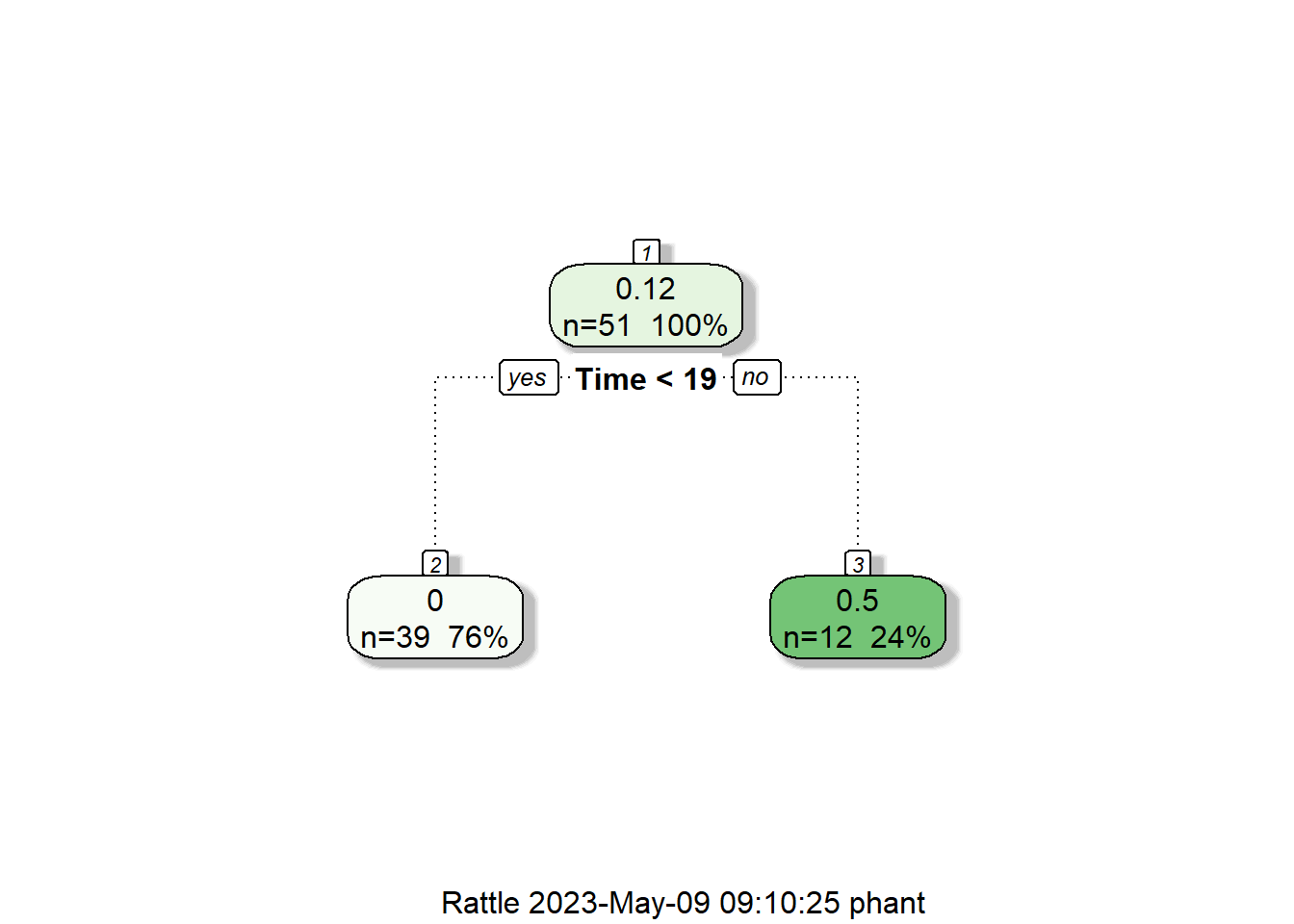

The tree is grown using a “divide and conquer” strategy, with repeated partitioning of the original data into smaller groups (nodes) on a yes or no basis. The method uses a splitting rule built around the notion of “purity.” A node in the tree is defined as pure when all the elements belong to one class. When there is impurity in the node, a split occurs to maximize reduction in “impurity.” In some cases, the split may be biased toward attributes that contain many different ordinal levels or scales. Thus, the selection of an attribute as the root node may vary according to the splitting rule and the scaling of the attribute. The decision tree package rpart does tolerate certain degree of missing number because the data are split using the available data for that attribute to calculate the Gini index (rather than the entire cohort). One major advantage of rpart is the presentation of the classification rules in the easily interpretable form of a tree. The hierarchical nature of the decision tree is similar to many decision processes (Phan et al. 2018).

## Loading required package: tibble## Loading required package: bitops## Rattle: A free graphical interface for data science with R.

## Version 5.4.0 Copyright (c) 2006-2020 Togaware Pty Ltd.

## Type 'rattle()' to shake, rattle, and roll your data.## [1] "Age" "Smear" "Infil" "Index" "Blasts" "Temp" "Resp" "Time"

## [9] "Status"#decision tree model for AML treatment

treLeukemia<-rpart(Status~., data=Leukemia)

fancyRpartPlot(treLeukemia)

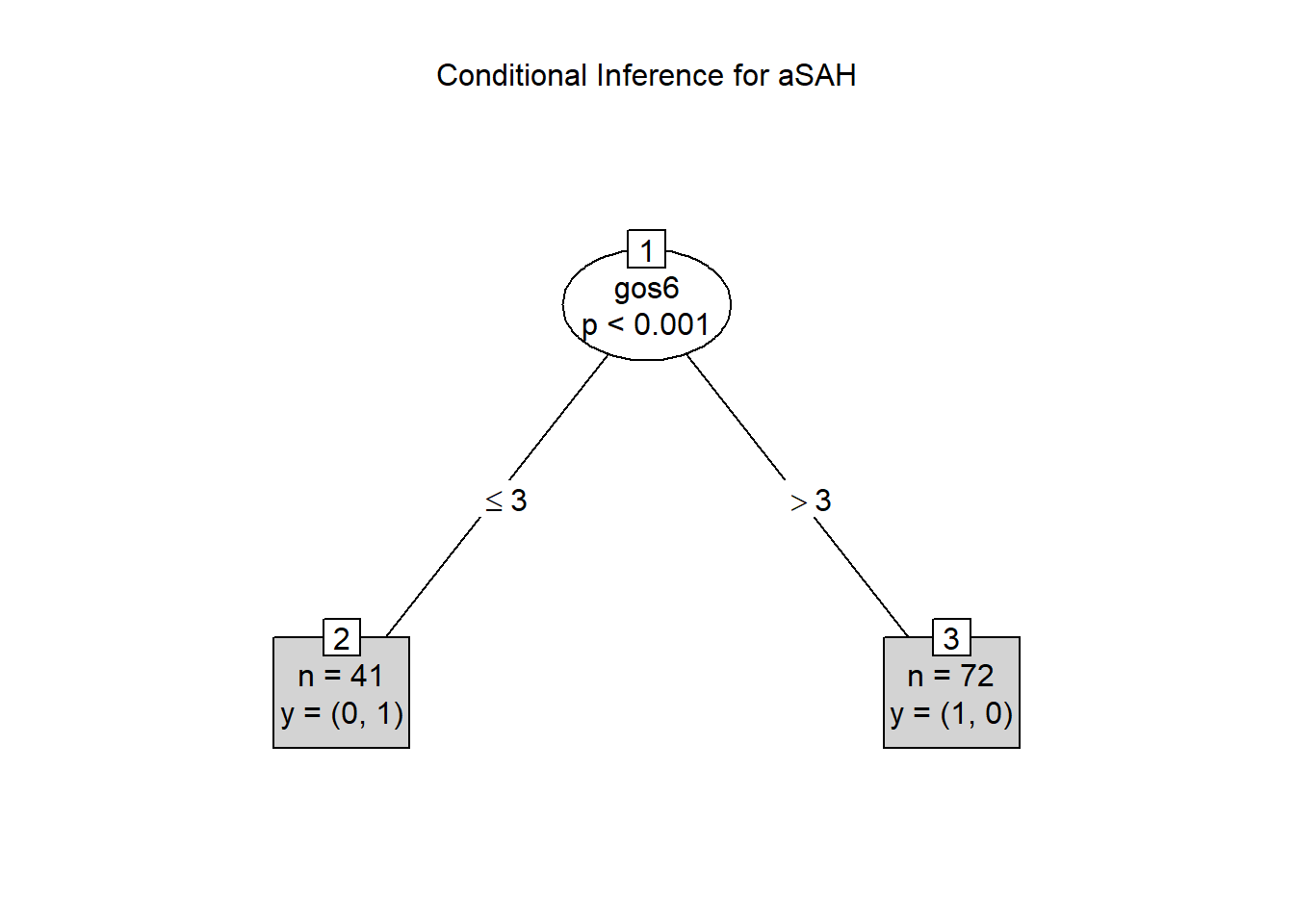

6.1.2 Conditional decision tree

The conditional decision tree approach has been proposed to be superior to CART method because that method uses information criterion for partitioning and which can lead to overfitting.The scenario of overfitting describes model which works well on training data but less so with new data.The conditional approach by party is less prone to overfitting as it includes significance testing (Phan et al. 2019).

## Loading required package: grid## Loading required package: mvtnorm## Loading required package: modeltools## Loading required package: stats4## Loading required package: strucchange## Loading required package: zoo##

## Attaching package: 'zoo'## The following objects are masked from 'package:base':

##

## as.Date, as.Date.numeric## Loading required package: sandwich## [1] "gos6" "outcome" "gender" "age" "wfns" "s100b" "ndka"#decision tree model

treeSAH<-ctree(outcome~., data=aSAH, control = ctree_control(mincriterion=0.95, minsplit=50))

plot(treeSAH,type = "simple",main = "Conditional Inference for aSAH")

6.1.3 criticisms of decision tree

Overfitting and prone to chosing variable with many levels are some disadvantage of decision tree. Decision tree do not handle collinearity issues well and the related method of random forest is proposed below.

6.2 Random Forest

Both gradient boost machine and random forest are examples of tree-based method with the former based on boosting of the residuals of the model and the latter based on bagging with random selection (rows and columns) of multiple subsets of the data. As such random forest regression ensembles the model from multiple decision trees. The trees are created by obtaining multiple subset of the data (random selection of data by rows and columns). Decision tree comes at certain disadvantage such as overfitting. Random forest avoids the problems of single decision tree analyses by aggregating the results of multiple trees obtained by performing analysis on random subsets of the original data. This method is different from the bootstrapping procedure that can be used in decision tree which may not change the data structure; hence the trees can look very similar. Random forest is available as randomForest or ranger or via caret.

A major drawback to random forest is that the hierarchical nature of the trees is lost. As such this method is seen as a black box tool and is less commonly embraced in the medical literature. One way us to use an interpretable machine learning tool iml (Molnar, Bischl, and Casalicchio 2018) (Shapley values) tool to aid interpretation of the model. This method uses ideas from coalition game theory to fairly distribute the contribution of the coalition of covariates to the random forest model.

The machine learning models are tuned using caret library.

## Loading required package: lattice## Loading required package: ggplot2data("BreastCancer",package = "mlbench")

#The Breast Cancer data contains NA as well as factors

#note Class is benign or malignant of class factor

#column Bare.nuclei removed due to NA

BreastCancer<-BreastCancer[,-c(1,7)]

#split data using caTools.

#The next example will use createDataPartition from caret

set.seed(123)

split = caTools::sample.split(BreastCancer$Class, SplitRatio = 0.75)

Train = subset(BreastCancer, split == TRUE)

Test = subset(BreastCancer, split == FALSE)

# specify that resampling method is

rf_control <- trainControl(## 10-fold CV

method = "cv",

number = 10)

#scaling data is performed here under preProcess

#note that ranger handles the outcome variable as factor

rf <- caret::train(Class ~ .,

data = Train,

method = "ranger",

trControl=rf_control,

preProcess = c("center", "scale"),

tuneLength = 10, verbose=F)

summary(rf)## Length Class Mode

## predictions 525 factor numeric

## num.trees 1 -none- numeric

## num.independent.variables 1 -none- numeric

## mtry 1 -none- numeric

## min.node.size 1 -none- numeric

## prediction.error 1 -none- numeric

## forest 9 ranger.forest list

## confusion.matrix 4 table numeric

## splitrule 1 -none- character

## num.random.splits 1 -none- numeric

## treetype 1 -none- character

## call 9 -none- call

## importance.mode 1 -none- character

## num.samples 1 -none- numeric

## replace 1 -none- logical

## xNames 71 -none- character

## problemType 1 -none- character

## tuneValue 3 data.frame list

## obsLevels 2 -none- character

## param 1 -none- list## Confusion Matrix and Statistics

##

## Reference

## Prediction benign malignant

## benign 455 6

## malignant 3 235

##

## Accuracy : 0.9871

## 95% CI : (0.9757, 0.9941)

## No Information Rate : 0.6552

## P-Value [Acc > NIR] : <2e-16

##

## Kappa : 0.9714

##

## Mcnemar's Test P-Value : 0.505

##

## Sensitivity : 0.9934

## Specificity : 0.9751

## Pos Pred Value : 0.9870

## Neg Pred Value : 0.9874

## Prevalence : 0.6552

## Detection Rate : 0.6509

## Detection Prevalence : 0.6595

## Balanced Accuracy : 0.9843

##

## 'Positive' Class : benign

## ## Setting levels: control = benign, case = malignant## Setting direction: controls < cases##

## Call:

## roc.default(response = BreastCancer$Class, predictor = as.numeric(pred_rf))

##

## Data: as.numeric(pred_rf) in 458 controls (BreastCancer$Class benign) < 241 cases (BreastCancer$Class malignant).

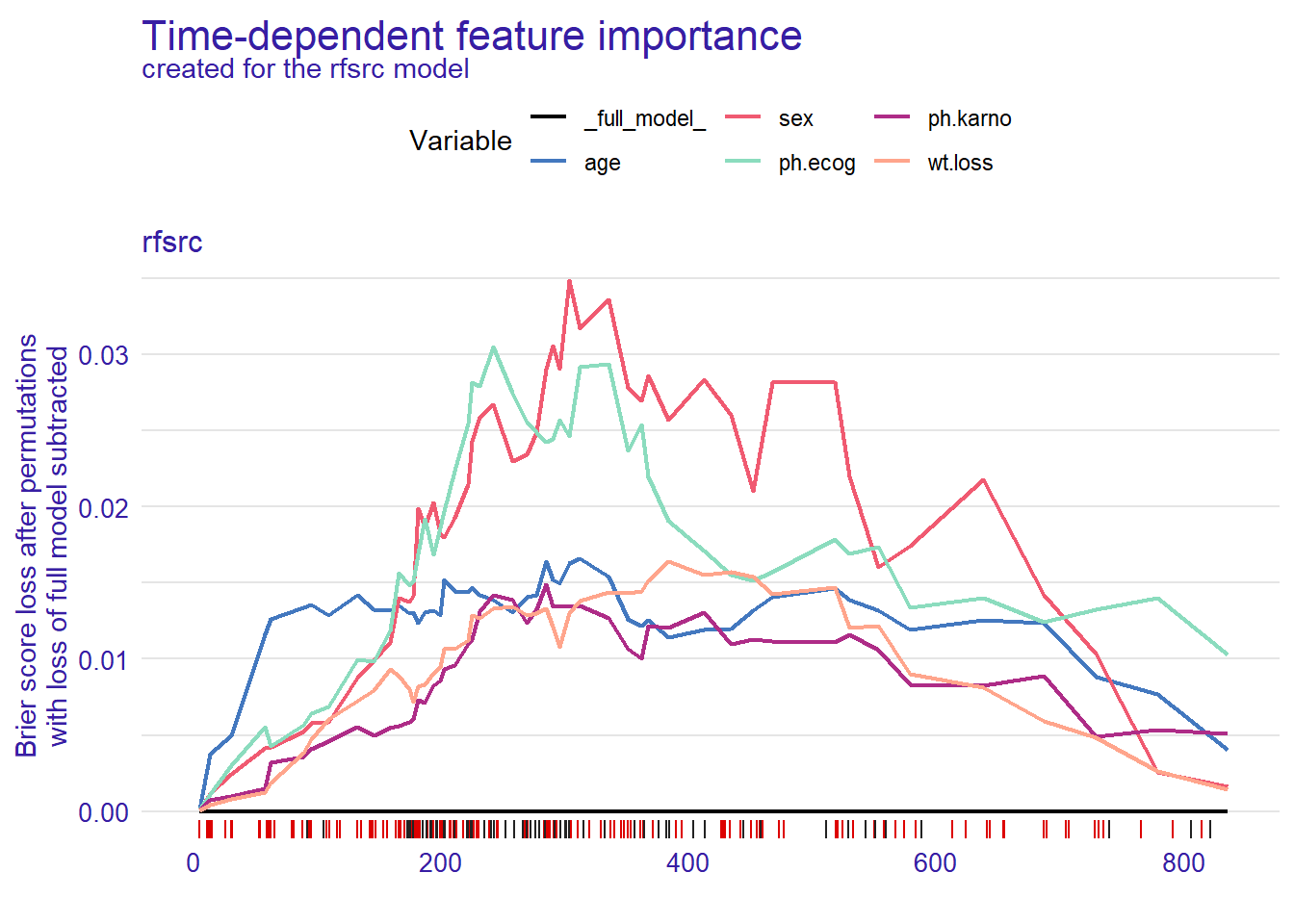

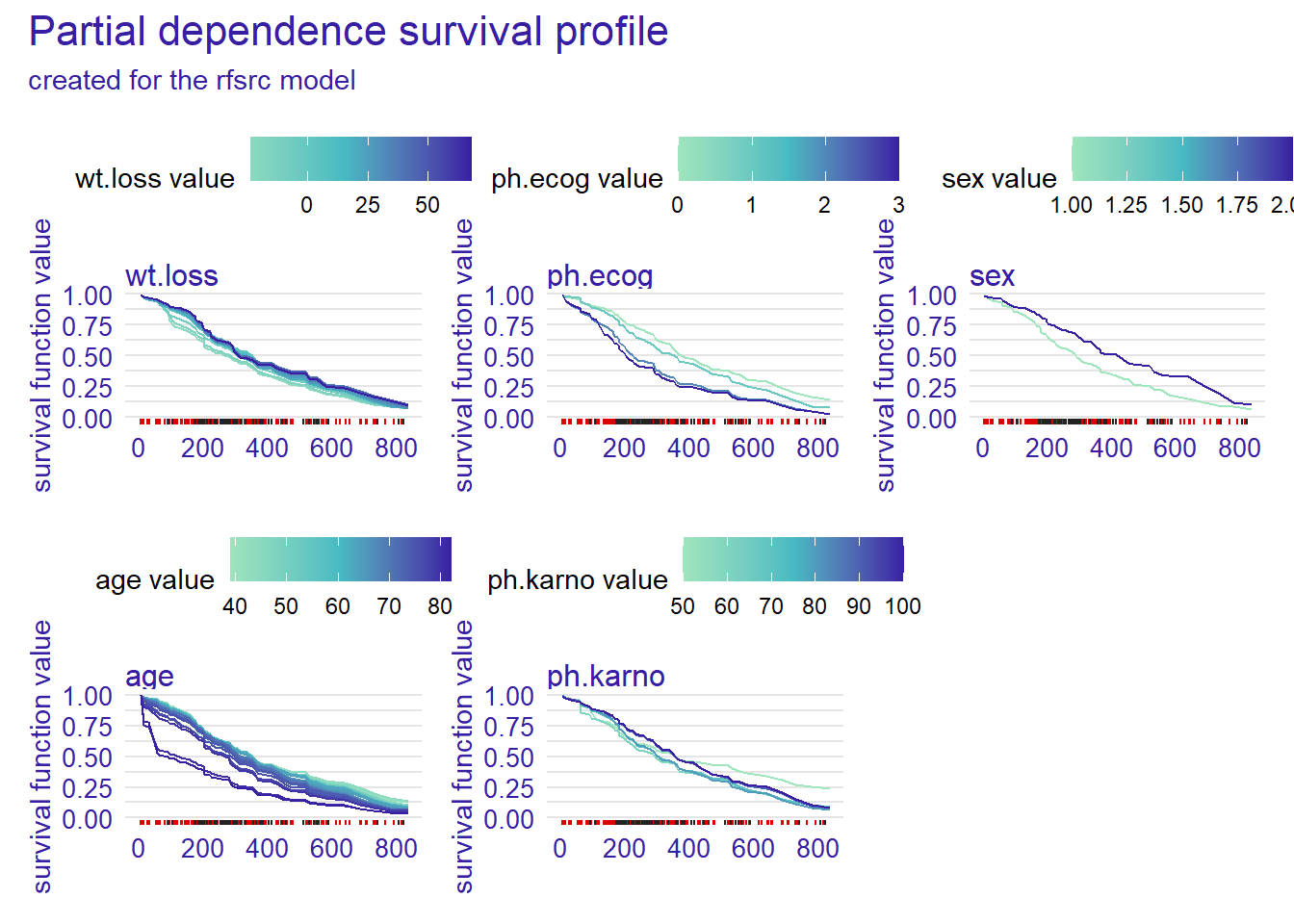

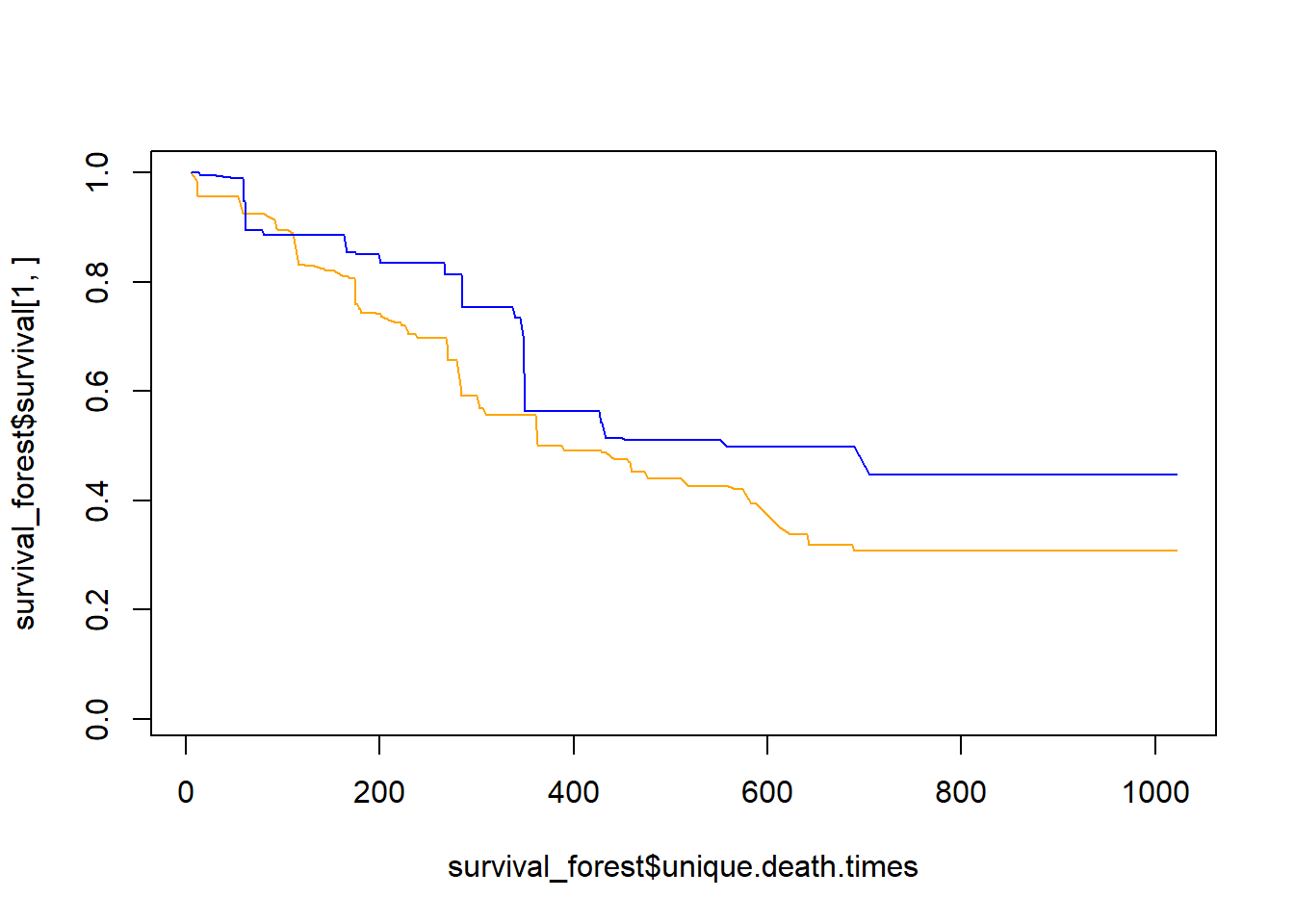

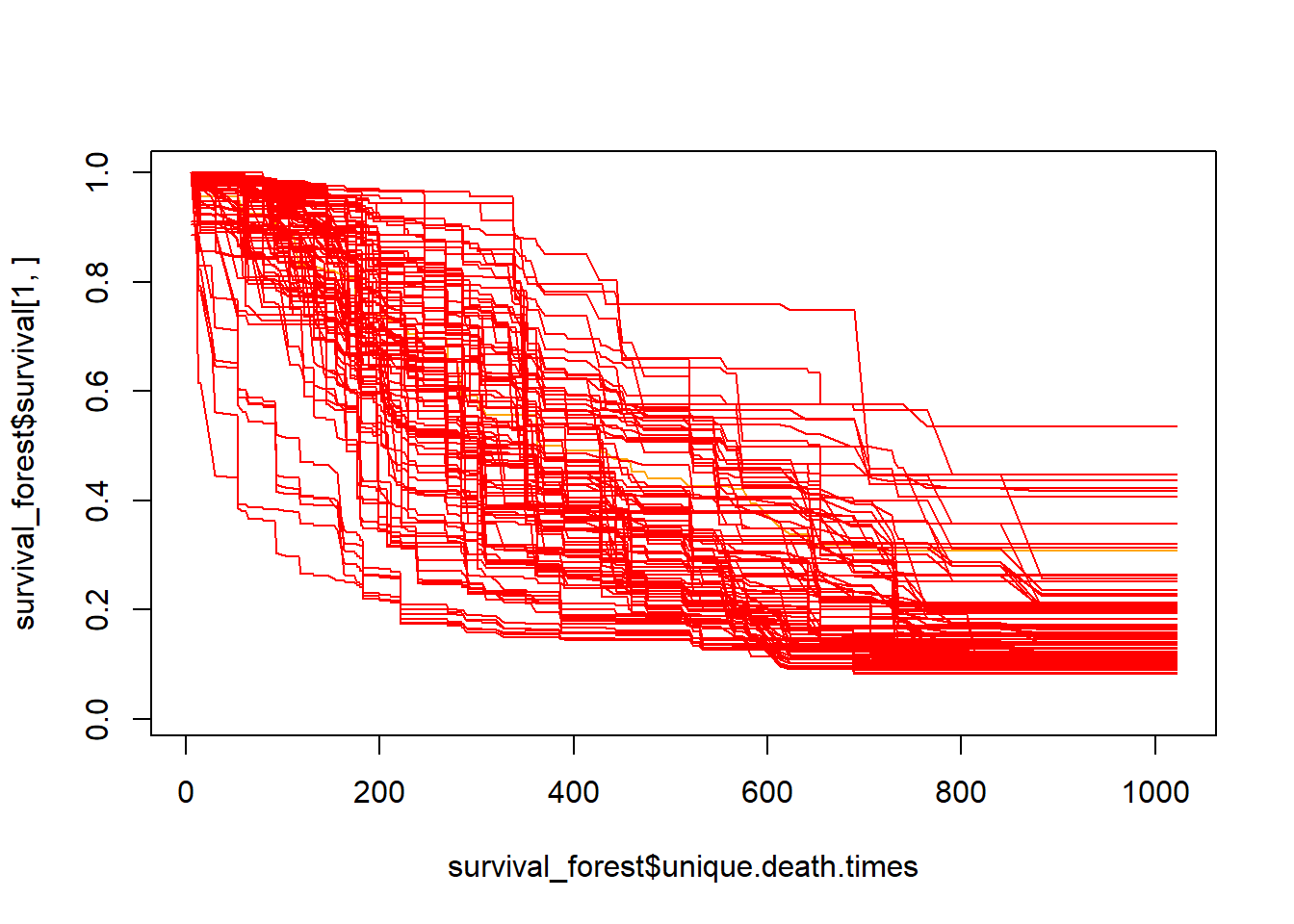

## Area under the curve: 0.98436.2.1 Random survival forest

Random survival forest example is provided below using rfsrc library. The survex library is used for explanation on the model.

##

## Attaching package: 'survival'## The following object is masked from 'package:caret':

##

## cluster## Loading required package: ggpubr##

## randomForestSRC 2.9.3

##

## Type rfsrc.news() to see new features, changes, and bug fixes.

## ##

## Attaching package: 'dplyr'## The following object is masked from 'package:survex':

##

## explain## The following objects are masked from 'package:stats':

##

## filter, lag## The following objects are masked from 'package:base':

##

## intersect, setdiff, setequal, union#data from survival package on NCCTG lung cancer trial

#https://stat.ethz.ch/R-manual/R-devel/library/survival/html/lung.html

data(cancer, package="survival")

#time in days

#status censored=1, dead=2

#sex:Male=1 Female=2

cancer2<- cancer %>% mutate(

status=ifelse(status==1,0,1)) %>%

rename(Dead=status, Days=time)

time=cancer2$Days

status=cancer2$Dead

RF<- rfsrc(Surv(Days, Dead) ~ age+sex+ph.ecog+ph.karno+wt.loss, data = cancer2)

#specify library to avoid confusion with dplyr

explainer<-survex::explain(RF)## Preparation of a new explainer is initiated

## -> model label : rfsrc ( [33m default [39m )

## -> data : 213 rows 5 cols ( extracted from the model )

## -> target variable : 213 values ( 151 events and 62 censored , censoring rate = 0.291 ) ( extracted from the model )

## -> times : 50 unique time points , min = 5 , mean = 304.1224 , median = 263.16 , max = 835.44

## -> times : ( generated from y as 50 time points being consecutive quantiles (0.00, 0.02, ..., 0.98) )

## -> predict function : sum over the predict_cumulative_hazard_function will be used ( [33m default [39m )

## -> predict survival function : stepfun based on predict.rfsrc()$survival will be used ( [33m default [39m )

## -> predict cumulative hazard function : stepfun based on predict.rfsrc()$chf will be used ( [33m default [39m )

## -> model_info : package randomForestSRC , ver. 2.9.3 , task survival ( [33m default [39m )

## A new explainer has been created!Dynamic AUC

y <- explainer$y

times <- explainer$times

surv <- explainer$predict_survival_function(RF, explainer$data, times)

cd_auc(y, surv = surv, times = times)## [1] 1.0000000 0.9299517 0.9133987 0.9150000 0.8784514 0.8738696 0.8492632

## [8] 0.8469945 0.8443018 0.8200707 0.8181943 0.8126263 0.7827403 0.7585305

## [15] 0.7703840 0.7680369 0.7674442 0.7616438 0.7524828 0.7506547 0.7638787

## [22] 0.7612142 0.7654211 0.7581189 0.7332627 0.7094356 0.7019078 0.7102041

## [29] 0.7105310 0.7056007 0.7075489 0.7109053 0.6989114 0.6901174 0.6906694

## [36] 0.7026007 0.6867102 0.6900591 0.7003147 0.7009741 0.7261286 0.7376953

## [43] 0.7469602 0.7449909 0.7498972 0.7805807 0.8130252 0.8342308 0.8758170

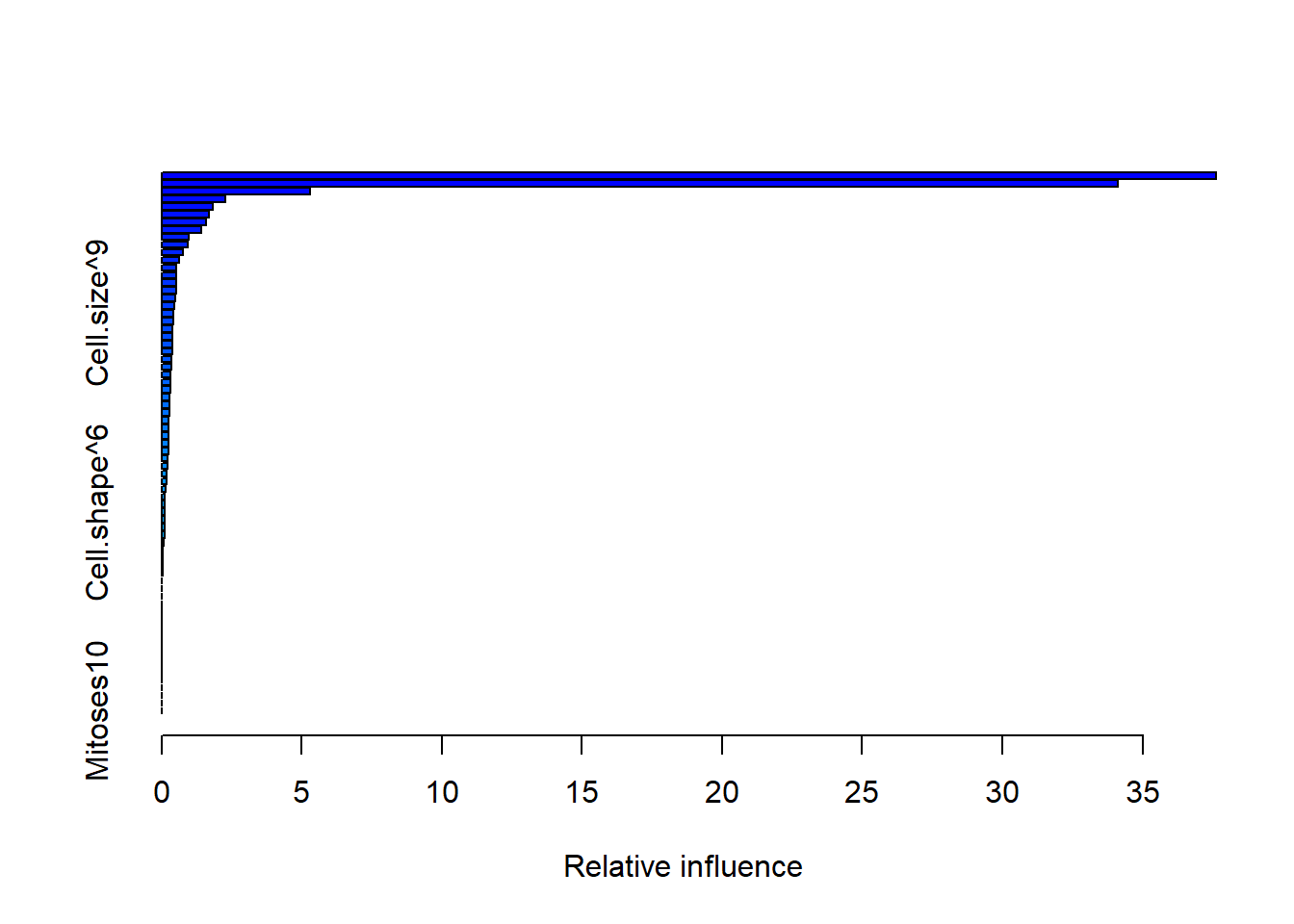

## [50] 0.9000000Plot variable importance for random survival forest using permutation of features and measure impact on Brier score.

Plot partial dependence

6.3 Gradient Boost Machine

Gradient boost machine is available as gradient boost machine_gbm.

#the breast cancer data from random forest is used here

# specify that the resampling method is

gbm_control <- trainControl(## 10-fold CV

method = "repeatedcv",

number = 10)

#scaling data is performed here under preProcess

#note that ranger handles the outcome variable as factor

gbm <- caret::train(Class ~ .,

data = Train,

method = "gbm",

trControl=gbm_control,

preProcess = c("center", "scale"),

tuneLength = 10)## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1522 nan 0.1000 0.0657

## 2 1.0452 nan 0.1000 0.0520

## 3 0.9465 nan 0.1000 0.0486

## 4 0.8699 nan 0.1000 0.0376

## 5 0.8031 nan 0.1000 0.0314

## 6 0.7480 nan 0.1000 0.0279

## 7 0.6949 nan 0.1000 0.0264

## 8 0.6500 nan 0.1000 0.0206

## 9 0.6110 nan 0.1000 0.0178

## 10 0.5772 nan 0.1000 0.0173

## 20 0.3674 nan 0.1000 0.0043

## 40 0.2291 nan 0.1000 -0.0004

## 60 0.1753 nan 0.1000 -0.0003

## 80 0.1502 nan 0.1000 -0.0001

## 100 0.1353 nan 0.1000 0.0000

## 120 0.1218 nan 0.1000 -0.0004

## 140 0.1114 nan 0.1000 0.0001

## 160 0.1033 nan 0.1000 -0.0006

## 180 0.1008 nan 0.1000 -0.0001

## 200 0.0958 nan 0.1000 -0.0012

## 220 0.0935 nan 0.1000 -0.0008

## 240 0.0880 nan 0.1000 0.0000

## 260 0.0851 nan 0.1000 -0.0002

## 280 0.0826 nan 0.1000 0.0002

## 300 0.0787 nan 0.1000 -0.0007

## 320 0.0760 nan 0.1000 -0.0002

## 340 0.0749 nan 0.1000 -0.0010

## 360 0.0730 nan 0.1000 -0.0008

## 380 0.0714 nan 0.1000 -0.0005

## 400 0.0707 nan 0.1000 -0.0011

## 420 0.0684 nan 0.1000 -0.0007

## 440 0.0677 nan 0.1000 -0.0006

## 460 0.0654 nan 0.1000 -0.0005

## 480 0.0642 nan 0.1000 -0.0004

## 500 0.0628 nan 0.1000 -0.0005

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1503 nan 0.1000 0.0720

## 2 1.0312 nan 0.1000 0.0637

## 3 0.9344 nan 0.1000 0.0459

## 4 0.8459 nan 0.1000 0.0426

## 5 0.7714 nan 0.1000 0.0350

## 6 0.7103 nan 0.1000 0.0297

## 7 0.6549 nan 0.1000 0.0252

## 8 0.6086 nan 0.1000 0.0224

## 9 0.5655 nan 0.1000 0.0203

## 10 0.5309 nan 0.1000 0.0142

## 20 0.3039 nan 0.1000 0.0034

## 40 0.1670 nan 0.1000 0.0004

## 60 0.1252 nan 0.1000 -0.0008

## 80 0.1025 nan 0.1000 -0.0005

## 100 0.0838 nan 0.1000 -0.0005

## 120 0.0725 nan 0.1000 -0.0004

## 140 0.0648 nan 0.1000 -0.0007

## 160 0.0567 nan 0.1000 0.0002

## 180 0.0512 nan 0.1000 -0.0002

## 200 0.0447 nan 0.1000 -0.0003

## 220 0.0395 nan 0.1000 -0.0004

## 240 0.0348 nan 0.1000 -0.0002

## 260 0.0322 nan 0.1000 -0.0004

## 280 0.0291 nan 0.1000 -0.0003

## 300 0.0266 nan 0.1000 -0.0002

## 320 0.0238 nan 0.1000 -0.0001

## 340 0.0226 nan 0.1000 -0.0002

## 360 0.0205 nan 0.1000 -0.0002

## 380 0.0184 nan 0.1000 -0.0001

## 400 0.0172 nan 0.1000 -0.0002

## 420 0.0160 nan 0.1000 -0.0002

## 440 0.0143 nan 0.1000 -0.0001

## 460 0.0130 nan 0.1000 -0.0002

## 480 0.0116 nan 0.1000 -0.0001

## 500 0.0104 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1391 nan 0.1000 0.0729

## 2 1.0123 nan 0.1000 0.0620

## 3 0.9073 nan 0.1000 0.0506

## 4 0.8186 nan 0.1000 0.0406

## 5 0.7505 nan 0.1000 0.0336

## 6 0.6854 nan 0.1000 0.0317

## 7 0.6319 nan 0.1000 0.0263

## 8 0.5862 nan 0.1000 0.0223

## 9 0.5435 nan 0.1000 0.0179

## 10 0.5077 nan 0.1000 0.0169

## 20 0.2713 nan 0.1000 0.0040

## 40 0.1418 nan 0.1000 -0.0008

## 60 0.0973 nan 0.1000 0.0001

## 80 0.0767 nan 0.1000 -0.0010

## 100 0.0585 nan 0.1000 -0.0004

## 120 0.0475 nan 0.1000 -0.0003

## 140 0.0378 nan 0.1000 -0.0001

## 160 0.0310 nan 0.1000 -0.0004

## 180 0.0259 nan 0.1000 -0.0004

## 200 0.0220 nan 0.1000 -0.0004

## 220 0.0181 nan 0.1000 -0.0002

## 240 0.0161 nan 0.1000 -0.0003

## 260 0.0134 nan 0.1000 -0.0002

## 280 0.0115 nan 0.1000 -0.0001

## 300 0.0099 nan 0.1000 -0.0001

## 320 0.0085 nan 0.1000 -0.0001

## 340 0.0074 nan 0.1000 -0.0001

## 360 0.0066 nan 0.1000 -0.0001

## 380 0.0055 nan 0.1000 -0.0000

## 400 0.0049 nan 0.1000 -0.0000

## 420 0.0043 nan 0.1000 -0.0000

## 440 0.0037 nan 0.1000 -0.0000

## 460 0.0031 nan 0.1000 -0.0000

## 480 0.0027 nan 0.1000 -0.0000

## 500 0.0024 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1380 nan 0.1000 0.0745

## 2 1.0151 nan 0.1000 0.0609

## 3 0.9125 nan 0.1000 0.0492

## 4 0.8251 nan 0.1000 0.0397

## 5 0.7505 nan 0.1000 0.0346

## 6 0.6840 nan 0.1000 0.0316

## 7 0.6268 nan 0.1000 0.0280

## 8 0.5754 nan 0.1000 0.0247

## 9 0.5327 nan 0.1000 0.0171

## 10 0.4934 nan 0.1000 0.0172

## 20 0.2630 nan 0.1000 0.0059

## 40 0.1275 nan 0.1000 -0.0006

## 60 0.0786 nan 0.1000 -0.0010

## 80 0.0552 nan 0.1000 -0.0007

## 100 0.0392 nan 0.1000 -0.0004

## 120 0.0289 nan 0.1000 -0.0004

## 140 0.0223 nan 0.1000 -0.0002

## 160 0.0176 nan 0.1000 -0.0002

## 180 0.0141 nan 0.1000 -0.0001

## 200 0.0107 nan 0.1000 -0.0001

## 220 0.0087 nan 0.1000 -0.0001

## 240 0.0068 nan 0.1000 -0.0000

## 260 0.0054 nan 0.1000 -0.0000

## 280 0.0043 nan 0.1000 -0.0001

## 300 0.0033 nan 0.1000 -0.0000

## 320 0.0027 nan 0.1000 -0.0000

## 340 0.0020 nan 0.1000 -0.0000

## 360 0.0016 nan 0.1000 -0.0000

## 380 0.0013 nan 0.1000 -0.0000

## 400 0.0011 nan 0.1000 -0.0000

## 420 0.0009 nan 0.1000 -0.0000

## 440 0.0007 nan 0.1000 -0.0000

## 460 0.0006 nan 0.1000 -0.0000

## 480 0.0005 nan 0.1000 -0.0000

## 500 0.0004 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1362 nan 0.1000 0.0781

## 2 1.0087 nan 0.1000 0.0624

## 3 0.8981 nan 0.1000 0.0531

## 4 0.8110 nan 0.1000 0.0422

## 5 0.7379 nan 0.1000 0.0332

## 6 0.6761 nan 0.1000 0.0292

## 7 0.6210 nan 0.1000 0.0253

## 8 0.5673 nan 0.1000 0.0240

## 9 0.5235 nan 0.1000 0.0211

## 10 0.4845 nan 0.1000 0.0180

## 20 0.2600 nan 0.1000 0.0042

## 40 0.1179 nan 0.1000 -0.0014

## 60 0.0721 nan 0.1000 -0.0015

## 80 0.0471 nan 0.1000 -0.0003

## 100 0.0323 nan 0.1000 -0.0004

## 120 0.0232 nan 0.1000 -0.0002

## 140 0.0173 nan 0.1000 -0.0002

## 160 0.0127 nan 0.1000 -0.0002

## 180 0.0093 nan 0.1000 -0.0000

## 200 0.0066 nan 0.1000 -0.0001

## 220 0.0055 nan 0.1000 -0.0001

## 240 0.0039 nan 0.1000 0.0000

## 260 0.0030 nan 0.1000 -0.0000

## 280 0.0021 nan 0.1000 -0.0000

## 300 0.0017 nan 0.1000 -0.0000

## 320 0.0014 nan 0.1000 -0.0000

## 340 0.0011 nan 0.1000 -0.0000

## 360 0.0008 nan 0.1000 -0.0000

## 380 0.0006 nan 0.1000 -0.0000

## 400 0.0005 nan 0.1000 -0.0000

## 420 0.0004 nan 0.1000 -0.0000

## 440 0.0003 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0002 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1368 nan 0.1000 0.0740

## 2 1.0143 nan 0.1000 0.0581

## 3 0.9146 nan 0.1000 0.0474

## 4 0.8273 nan 0.1000 0.0431

## 5 0.7535 nan 0.1000 0.0343

## 6 0.6904 nan 0.1000 0.0313

## 7 0.6320 nan 0.1000 0.0263

## 8 0.5784 nan 0.1000 0.0246

## 9 0.5362 nan 0.1000 0.0180

## 10 0.4980 nan 0.1000 0.0148

## 20 0.2605 nan 0.1000 0.0038

## 40 0.1074 nan 0.1000 -0.0018

## 60 0.0587 nan 0.1000 -0.0010

## 80 0.0384 nan 0.1000 -0.0004

## 100 0.0248 nan 0.1000 -0.0005

## 120 0.0176 nan 0.1000 -0.0004

## 140 0.0124 nan 0.1000 -0.0001

## 160 0.0085 nan 0.1000 -0.0001

## 180 0.0058 nan 0.1000 -0.0001

## 200 0.0042 nan 0.1000 -0.0000

## 220 0.0030 nan 0.1000 -0.0000

## 240 0.0023 nan 0.1000 -0.0000

## 260 0.0017 nan 0.1000 -0.0001

## 280 0.0012 nan 0.1000 -0.0000

## 300 0.0009 nan 0.1000 -0.0000

## 320 0.0007 nan 0.1000 -0.0000

## 340 0.0006 nan 0.1000 -0.0000

## 360 0.0004 nan 0.1000 -0.0000

## 380 0.0003 nan 0.1000 0.0000

## 400 0.0002 nan 0.1000 -0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1362 nan 0.1000 0.0753

## 2 1.0097 nan 0.1000 0.0619

## 3 0.9048 nan 0.1000 0.0515

## 4 0.8158 nan 0.1000 0.0413

## 5 0.7373 nan 0.1000 0.0372

## 6 0.6690 nan 0.1000 0.0321

## 7 0.6114 nan 0.1000 0.0272

## 8 0.5631 nan 0.1000 0.0221

## 9 0.5219 nan 0.1000 0.0174

## 10 0.4847 nan 0.1000 0.0164

## 20 0.2624 nan 0.1000 0.0046

## 40 0.1023 nan 0.1000 -0.0003

## 60 0.0598 nan 0.1000 -0.0010

## 80 0.0373 nan 0.1000 -0.0007

## 100 0.0229 nan 0.1000 -0.0002

## 120 0.0161 nan 0.1000 -0.0003

## 140 0.0118 nan 0.1000 -0.0004

## 160 0.0087 nan 0.1000 -0.0001

## 180 0.0060 nan 0.1000 0.0000

## 200 0.0044 nan 0.1000 -0.0001

## 220 0.0031 nan 0.1000 -0.0001

## 240 0.0021 nan 0.1000 -0.0000

## 260 0.0016 nan 0.1000 -0.0000

## 280 0.0010 nan 0.1000 -0.0000

## 300 0.0007 nan 0.1000 -0.0000

## 320 0.0005 nan 0.1000 -0.0000

## 340 0.0004 nan 0.1000 -0.0000

## 360 0.0003 nan 0.1000 -0.0000

## 380 0.0002 nan 0.1000 -0.0000

## 400 0.0001 nan 0.1000 -0.0000

## 420 0.0001 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 0.0000

## 480 0.0000 nan 0.1000 -0.0000

## 500 0.0000 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1338 nan 0.1000 0.0751

## 2 1.0053 nan 0.1000 0.0580

## 3 0.9014 nan 0.1000 0.0491

## 4 0.8204 nan 0.1000 0.0394

## 5 0.7435 nan 0.1000 0.0356

## 6 0.6761 nan 0.1000 0.0314

## 7 0.6180 nan 0.1000 0.0278

## 8 0.5678 nan 0.1000 0.0228

## 9 0.5224 nan 0.1000 0.0205

## 10 0.4835 nan 0.1000 0.0182

## 20 0.2562 nan 0.1000 0.0039

## 40 0.1050 nan 0.1000 0.0002

## 60 0.0602 nan 0.1000 0.0000

## 80 0.0363 nan 0.1000 -0.0009

## 100 0.0215 nan 0.1000 -0.0003

## 120 0.0152 nan 0.1000 -0.0001

## 140 0.0097 nan 0.1000 -0.0000

## 160 0.0069 nan 0.1000 -0.0001

## 180 0.0050 nan 0.1000 -0.0001

## 200 0.0036 nan 0.1000 -0.0001

## 220 0.0023 nan 0.1000 0.0000

## 240 0.0015 nan 0.1000 -0.0000

## 260 0.0011 nan 0.1000 -0.0000

## 280 0.0008 nan 0.1000 -0.0000

## 300 0.0006 nan 0.1000 -0.0000

## 320 0.0005 nan 0.1000 -0.0000

## 340 0.0003 nan 0.1000 -0.0000

## 360 0.0003 nan 0.1000 -0.0000

## 380 0.0002 nan 0.1000 -0.0000

## 400 0.0001 nan 0.1000 -0.0000

## 420 0.0001 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0000 nan 0.1000 -0.0000

## 500 0.0000 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1314 nan 0.1000 0.0719

## 2 1.0135 nan 0.1000 0.0594

## 3 0.9168 nan 0.1000 0.0447

## 4 0.8288 nan 0.1000 0.0413

## 5 0.7542 nan 0.1000 0.0375

## 6 0.6882 nan 0.1000 0.0303

## 7 0.6293 nan 0.1000 0.0268

## 8 0.5776 nan 0.1000 0.0238

## 9 0.5313 nan 0.1000 0.0200

## 10 0.4949 nan 0.1000 0.0154

## 20 0.2559 nan 0.1000 0.0031

## 40 0.1015 nan 0.1000 0.0014

## 60 0.0533 nan 0.1000 -0.0001

## 80 0.0317 nan 0.1000 -0.0004

## 100 0.0221 nan 0.1000 -0.0003

## 120 0.0147 nan 0.1000 -0.0002

## 140 0.0097 nan 0.1000 -0.0003

## 160 0.0073 nan 0.1000 -0.0002

## 180 0.0055 nan 0.1000 -0.0002

## 200 0.0034 nan 0.1000 -0.0001

## 220 0.0020 nan 0.1000 0.0000

## 240 0.0016 nan 0.1000 -0.0000

## 260 0.0012 nan 0.1000 -0.0000

## 280 0.0009 nan 0.1000 0.0000

## 300 0.0007 nan 0.1000 0.0000

## 320 0.0006 nan 0.1000 -0.0000

## 340 0.0004 nan 0.1000 0.0000

## 360 0.0003 nan 0.1000 -0.0000

## 380 0.0002 nan 0.1000 -0.0000

## 400 0.0001 nan 0.1000 0.0000

## 420 0.0001 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1379 nan 0.1000 0.0704

## 2 1.0121 nan 0.1000 0.0599

## 3 0.9038 nan 0.1000 0.0500

## 4 0.8195 nan 0.1000 0.0422

## 5 0.7441 nan 0.1000 0.0339

## 6 0.6852 nan 0.1000 0.0265

## 7 0.6269 nan 0.1000 0.0281

## 8 0.5777 nan 0.1000 0.0202

## 9 0.5340 nan 0.1000 0.0205

## 10 0.4959 nan 0.1000 0.0166

## 20 0.2599 nan 0.1000 0.0053

## 40 0.1110 nan 0.1000 0.0003

## 60 0.0573 nan 0.1000 -0.0006

## 80 0.0356 nan 0.1000 -0.0004

## 100 0.0251 nan 0.1000 -0.0002

## 120 0.0181 nan 0.1000 0.0001

## 140 0.0134 nan 0.1000 -0.0005

## 160 0.0101 nan 0.1000 -0.0003

## 180 0.0075 nan 0.1000 -0.0001

## 200 0.0052 nan 0.1000 -0.0000

## 220 0.0039 nan 0.1000 -0.0001

## 240 0.0031 nan 0.1000 -0.0001

## 260 0.0023 nan 0.1000 -0.0000

## 280 0.0017 nan 0.1000 -0.0000

## 300 0.0013 nan 0.1000 -0.0000

## 320 0.0011 nan 0.1000 -0.0000

## 340 0.0008 nan 0.1000 -0.0000

## 360 0.0006 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 -0.0000

## 400 0.0004 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0003 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1483 nan 0.1000 0.0660

## 2 1.0427 nan 0.1000 0.0513

## 3 0.9512 nan 0.1000 0.0461

## 4 0.8777 nan 0.1000 0.0373

## 5 0.8136 nan 0.1000 0.0320

## 6 0.7544 nan 0.1000 0.0285

## 7 0.7039 nan 0.1000 0.0226

## 8 0.6653 nan 0.1000 0.0171

## 9 0.6268 nan 0.1000 0.0173

## 10 0.5916 nan 0.1000 0.0158

## 20 0.3881 nan 0.1000 0.0057

## 40 0.2439 nan 0.1000 0.0008

## 60 0.2027 nan 0.1000 0.0009

## 80 0.1778 nan 0.1000 -0.0006

## 100 0.1659 nan 0.1000 -0.0008

## 120 0.1523 nan 0.1000 -0.0007

## 140 0.1446 nan 0.1000 -0.0007

## 160 0.1382 nan 0.1000 -0.0007

## 180 0.1328 nan 0.1000 -0.0003

## 200 0.1293 nan 0.1000 -0.0005

## 220 0.1271 nan 0.1000 -0.0018

## 240 0.1199 nan 0.1000 -0.0008

## 260 0.1169 nan 0.1000 -0.0011

## 280 0.1139 nan 0.1000 -0.0004

## 300 0.1080 nan 0.1000 -0.0009

## 320 0.1057 nan 0.1000 -0.0008

## 340 0.1019 nan 0.1000 -0.0007

## 360 0.1016 nan 0.1000 -0.0016

## 380 0.1010 nan 0.1000 -0.0008

## 400 0.1002 nan 0.1000 -0.0004

## 420 0.0992 nan 0.1000 -0.0008

## 440 0.0970 nan 0.1000 -0.0008

## 460 0.0962 nan 0.1000 -0.0005

## 480 0.0945 nan 0.1000 -0.0004

## 500 0.0939 nan 0.1000 -0.0006

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1342 nan 0.1000 0.0714

## 2 1.0162 nan 0.1000 0.0592

## 3 0.9188 nan 0.1000 0.0460

## 4 0.8413 nan 0.1000 0.0370

## 5 0.7696 nan 0.1000 0.0350

## 6 0.7082 nan 0.1000 0.0279

## 7 0.6599 nan 0.1000 0.0223

## 8 0.6125 nan 0.1000 0.0225

## 9 0.5724 nan 0.1000 0.0190

## 10 0.5350 nan 0.1000 0.0153

## 20 0.3143 nan 0.1000 0.0055

## 40 0.1901 nan 0.1000 -0.0010

## 60 0.1475 nan 0.1000 -0.0014

## 80 0.1207 nan 0.1000 -0.0000

## 100 0.1060 nan 0.1000 -0.0002

## 120 0.0948 nan 0.1000 -0.0009

## 140 0.0815 nan 0.1000 -0.0002

## 160 0.0722 nan 0.1000 -0.0007

## 180 0.0657 nan 0.1000 -0.0007

## 200 0.0592 nan 0.1000 -0.0004

## 220 0.0539 nan 0.1000 -0.0001

## 240 0.0483 nan 0.1000 -0.0002

## 260 0.0445 nan 0.1000 -0.0004

## 280 0.0395 nan 0.1000 -0.0002

## 300 0.0365 nan 0.1000 -0.0004

## 320 0.0336 nan 0.1000 -0.0002

## 340 0.0315 nan 0.1000 -0.0003

## 360 0.0283 nan 0.1000 -0.0001

## 380 0.0258 nan 0.1000 -0.0003

## 400 0.0244 nan 0.1000 -0.0002

## 420 0.0224 nan 0.1000 -0.0001

## 440 0.0208 nan 0.1000 -0.0001

## 460 0.0192 nan 0.1000 -0.0003

## 480 0.0179 nan 0.1000 -0.0002

## 500 0.0161 nan 0.1000 -0.0001

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1377 nan 0.1000 0.0749

## 2 1.0149 nan 0.1000 0.0601

## 3 0.9142 nan 0.1000 0.0466

## 4 0.8282 nan 0.1000 0.0361

## 5 0.7581 nan 0.1000 0.0347

## 6 0.6939 nan 0.1000 0.0311

## 7 0.6386 nan 0.1000 0.0259

## 8 0.5934 nan 0.1000 0.0225

## 9 0.5536 nan 0.1000 0.0170

## 10 0.5165 nan 0.1000 0.0174

## 20 0.2941 nan 0.1000 0.0048

## 40 0.1628 nan 0.1000 -0.0013

## 60 0.1102 nan 0.1000 0.0010

## 80 0.0862 nan 0.1000 -0.0005

## 100 0.0690 nan 0.1000 -0.0007

## 120 0.0574 nan 0.1000 -0.0007

## 140 0.0469 nan 0.1000 -0.0004

## 160 0.0405 nan 0.1000 -0.0004

## 180 0.0331 nan 0.1000 -0.0001

## 200 0.0277 nan 0.1000 -0.0005

## 220 0.0223 nan 0.1000 -0.0001

## 240 0.0193 nan 0.1000 -0.0001

## 260 0.0168 nan 0.1000 -0.0001

## 280 0.0143 nan 0.1000 -0.0001

## 300 0.0119 nan 0.1000 -0.0001

## 320 0.0106 nan 0.1000 -0.0001

## 340 0.0089 nan 0.1000 -0.0001

## 360 0.0081 nan 0.1000 -0.0001

## 380 0.0069 nan 0.1000 -0.0001

## 400 0.0060 nan 0.1000 -0.0001

## 420 0.0051 nan 0.1000 0.0000

## 440 0.0043 nan 0.1000 -0.0000

## 460 0.0038 nan 0.1000 -0.0000

## 480 0.0033 nan 0.1000 -0.0000

## 500 0.0029 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1268 nan 0.1000 0.0769

## 2 1.0068 nan 0.1000 0.0570

## 3 0.9047 nan 0.1000 0.0476

## 4 0.8184 nan 0.1000 0.0406

## 5 0.7421 nan 0.1000 0.0367

## 6 0.6809 nan 0.1000 0.0277

## 7 0.6272 nan 0.1000 0.0232

## 8 0.5772 nan 0.1000 0.0221

## 9 0.5371 nan 0.1000 0.0174

## 10 0.5009 nan 0.1000 0.0172

## 20 0.2771 nan 0.1000 0.0049

## 40 0.1423 nan 0.1000 0.0011

## 60 0.0903 nan 0.1000 0.0003

## 80 0.0657 nan 0.1000 -0.0002

## 100 0.0507 nan 0.1000 -0.0007

## 120 0.0402 nan 0.1000 -0.0009

## 140 0.0309 nan 0.1000 -0.0001

## 160 0.0246 nan 0.1000 -0.0000

## 180 0.0200 nan 0.1000 -0.0004

## 200 0.0154 nan 0.1000 -0.0001

## 220 0.0129 nan 0.1000 -0.0002

## 240 0.0104 nan 0.1000 -0.0000

## 260 0.0088 nan 0.1000 -0.0001

## 280 0.0069 nan 0.1000 -0.0000

## 300 0.0056 nan 0.1000 -0.0001

## 320 0.0046 nan 0.1000 -0.0001

## 340 0.0037 nan 0.1000 0.0000

## 360 0.0030 nan 0.1000 -0.0000

## 380 0.0025 nan 0.1000 -0.0000

## 400 0.0020 nan 0.1000 -0.0000

## 420 0.0016 nan 0.1000 -0.0000

## 440 0.0013 nan 0.1000 -0.0000

## 460 0.0011 nan 0.1000 -0.0000

## 480 0.0009 nan 0.1000 -0.0000

## 500 0.0008 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1352 nan 0.1000 0.0716

## 2 1.0122 nan 0.1000 0.0583

## 3 0.9094 nan 0.1000 0.0471

## 4 0.8230 nan 0.1000 0.0373

## 5 0.7545 nan 0.1000 0.0325

## 6 0.6911 nan 0.1000 0.0294

## 7 0.6314 nan 0.1000 0.0254

## 8 0.5820 nan 0.1000 0.0214

## 9 0.5415 nan 0.1000 0.0186

## 10 0.5072 nan 0.1000 0.0140

## 20 0.2781 nan 0.1000 0.0048

## 40 0.1322 nan 0.1000 0.0001

## 60 0.0830 nan 0.1000 -0.0007

## 80 0.0559 nan 0.1000 -0.0006

## 100 0.0416 nan 0.1000 -0.0007

## 120 0.0303 nan 0.1000 -0.0005

## 140 0.0225 nan 0.1000 -0.0004

## 160 0.0166 nan 0.1000 -0.0001

## 180 0.0126 nan 0.1000 -0.0003

## 200 0.0099 nan 0.1000 -0.0002

## 220 0.0073 nan 0.1000 -0.0001

## 240 0.0053 nan 0.1000 -0.0000

## 260 0.0042 nan 0.1000 -0.0001

## 280 0.0034 nan 0.1000 -0.0000

## 300 0.0026 nan 0.1000 -0.0000

## 320 0.0020 nan 0.1000 -0.0000

## 340 0.0015 nan 0.1000 -0.0000

## 360 0.0012 nan 0.1000 -0.0000

## 380 0.0010 nan 0.1000 -0.0000

## 400 0.0008 nan 0.1000 -0.0000

## 420 0.0006 nan 0.1000 -0.0000

## 440 0.0005 nan 0.1000 -0.0000

## 460 0.0004 nan 0.1000 -0.0000

## 480 0.0003 nan 0.1000 -0.0000

## 500 0.0002 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1333 nan 0.1000 0.0751

## 2 1.0097 nan 0.1000 0.0589

## 3 0.9126 nan 0.1000 0.0451

## 4 0.8283 nan 0.1000 0.0422

## 5 0.7567 nan 0.1000 0.0343

## 6 0.6897 nan 0.1000 0.0305

## 7 0.6350 nan 0.1000 0.0244

## 8 0.5859 nan 0.1000 0.0235

## 9 0.5402 nan 0.1000 0.0228

## 10 0.5023 nan 0.1000 0.0156

## 20 0.2756 nan 0.1000 0.0047

## 40 0.1234 nan 0.1000 0.0005

## 60 0.0692 nan 0.1000 0.0001

## 80 0.0460 nan 0.1000 -0.0007

## 100 0.0345 nan 0.1000 -0.0001

## 120 0.0264 nan 0.1000 -0.0005

## 140 0.0186 nan 0.1000 -0.0004

## 160 0.0130 nan 0.1000 -0.0002

## 180 0.0097 nan 0.1000 -0.0001

## 200 0.0073 nan 0.1000 -0.0001

## 220 0.0057 nan 0.1000 -0.0001

## 240 0.0041 nan 0.1000 -0.0001

## 260 0.0030 nan 0.1000 -0.0000

## 280 0.0024 nan 0.1000 -0.0000

## 300 0.0018 nan 0.1000 -0.0000

## 320 0.0013 nan 0.1000 -0.0000

## 340 0.0009 nan 0.1000 -0.0000

## 360 0.0006 nan 0.1000 0.0000

## 380 0.0004 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1362 nan 0.1000 0.0723

## 2 1.0098 nan 0.1000 0.0587

## 3 0.9041 nan 0.1000 0.0466

## 4 0.8182 nan 0.1000 0.0382

## 5 0.7424 nan 0.1000 0.0329

## 6 0.6810 nan 0.1000 0.0280

## 7 0.6232 nan 0.1000 0.0262

## 8 0.5750 nan 0.1000 0.0234

## 9 0.5335 nan 0.1000 0.0178

## 10 0.4975 nan 0.1000 0.0150

## 20 0.2712 nan 0.1000 0.0043

## 40 0.1243 nan 0.1000 0.0002

## 60 0.0689 nan 0.1000 -0.0006

## 80 0.0453 nan 0.1000 -0.0001

## 100 0.0326 nan 0.1000 -0.0010

## 120 0.0233 nan 0.1000 -0.0002

## 140 0.0165 nan 0.1000 0.0001

## 160 0.0108 nan 0.1000 -0.0001

## 180 0.0082 nan 0.1000 -0.0001

## 200 0.0055 nan 0.1000 -0.0002

## 220 0.0045 nan 0.1000 -0.0001

## 240 0.0035 nan 0.1000 -0.0000

## 260 0.0025 nan 0.1000 -0.0000

## 280 0.0020 nan 0.1000 -0.0000

## 300 0.0014 nan 0.1000 -0.0000

## 320 0.0010 nan 0.1000 -0.0000

## 340 0.0007 nan 0.1000 -0.0000

## 360 0.0006 nan 0.1000 0.0000

## 380 0.0004 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 -0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1344 nan 0.1000 0.0753

## 2 1.0097 nan 0.1000 0.0569

## 3 0.9104 nan 0.1000 0.0496

## 4 0.8270 nan 0.1000 0.0390

## 5 0.7474 nan 0.1000 0.0354

## 6 0.6879 nan 0.1000 0.0265

## 7 0.6305 nan 0.1000 0.0264

## 8 0.5832 nan 0.1000 0.0200

## 9 0.5407 nan 0.1000 0.0182

## 10 0.5000 nan 0.1000 0.0184

## 20 0.2737 nan 0.1000 0.0047

## 40 0.1187 nan 0.1000 -0.0003

## 60 0.0636 nan 0.1000 -0.0010

## 80 0.0411 nan 0.1000 -0.0014

## 100 0.0287 nan 0.1000 -0.0004

## 120 0.0183 nan 0.1000 -0.0001

## 140 0.0131 nan 0.1000 -0.0002

## 160 0.0087 nan 0.1000 -0.0001

## 180 0.0065 nan 0.1000 -0.0002

## 200 0.0047 nan 0.1000 -0.0002

## 220 0.0033 nan 0.1000 -0.0001

## 240 0.0025 nan 0.1000 -0.0000

## 260 0.0018 nan 0.1000 -0.0001

## 280 0.0013 nan 0.1000 -0.0000

## 300 0.0010 nan 0.1000 -0.0000

## 320 0.0008 nan 0.1000 -0.0000

## 340 0.0006 nan 0.1000 -0.0000

## 360 0.0004 nan 0.1000 -0.0000

## 380 0.0003 nan 0.1000 -0.0000

## 400 0.0002 nan 0.1000 -0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 0.0000

## 500 0.0001 nan 0.1000 0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1384 nan 0.1000 0.0748

## 2 1.0172 nan 0.1000 0.0554

## 3 0.9119 nan 0.1000 0.0501

## 4 0.8252 nan 0.1000 0.0405

## 5 0.7552 nan 0.1000 0.0345

## 6 0.6944 nan 0.1000 0.0273

## 7 0.6340 nan 0.1000 0.0266

## 8 0.5883 nan 0.1000 0.0198

## 9 0.5441 nan 0.1000 0.0181

## 10 0.5037 nan 0.1000 0.0196

## 20 0.2750 nan 0.1000 0.0051

## 40 0.1137 nan 0.1000 -0.0003

## 60 0.0623 nan 0.1000 -0.0006

## 80 0.0393 nan 0.1000 -0.0004

## 100 0.0254 nan 0.1000 -0.0003

## 120 0.0166 nan 0.1000 -0.0002

## 140 0.0120 nan 0.1000 -0.0001

## 160 0.0088 nan 0.1000 -0.0001

## 180 0.0063 nan 0.1000 -0.0001

## 200 0.0050 nan 0.1000 0.0000

## 220 0.0039 nan 0.1000 -0.0001

## 240 0.0031 nan 0.1000 -0.0001

## 260 0.0026 nan 0.1000 -0.0001

## 280 0.0017 nan 0.1000 -0.0000

## 300 0.0012 nan 0.1000 -0.0000

## 320 0.0009 nan 0.1000 -0.0000

## 340 0.0007 nan 0.1000 -0.0000

## 360 0.0005 nan 0.1000 -0.0000

## 380 0.0004 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1418 nan 0.1000 0.0772

## 2 1.0151 nan 0.1000 0.0588

## 3 0.9132 nan 0.1000 0.0535

## 4 0.8245 nan 0.1000 0.0420

## 5 0.7454 nan 0.1000 0.0350

## 6 0.6795 nan 0.1000 0.0312

## 7 0.6274 nan 0.1000 0.0251

## 8 0.5798 nan 0.1000 0.0201

## 9 0.5369 nan 0.1000 0.0193

## 10 0.5000 nan 0.1000 0.0148

## 20 0.2787 nan 0.1000 0.0050

## 40 0.1210 nan 0.1000 -0.0007

## 60 0.0626 nan 0.1000 -0.0007

## 80 0.0380 nan 0.1000 -0.0008

## 100 0.0244 nan 0.1000 -0.0003

## 120 0.0159 nan 0.1000 -0.0002

## 140 0.0103 nan 0.1000 -0.0000

## 160 0.0070 nan 0.1000 -0.0001

## 180 0.0052 nan 0.1000 -0.0000

## 200 0.0041 nan 0.1000 -0.0001

## 220 0.0031 nan 0.1000 -0.0000

## 240 0.0022 nan 0.1000 0.0000

## 260 0.0017 nan 0.1000 -0.0001

## 280 0.0014 nan 0.1000 -0.0000

## 300 0.0010 nan 0.1000 -0.0000

## 320 0.0006 nan 0.1000 -0.0000

## 340 0.0005 nan 0.1000 -0.0000

## 360 0.0004 nan 0.1000 -0.0000

## 380 0.0003 nan 0.1000 -0.0000

## 400 0.0002 nan 0.1000 0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1613 nan 0.1000 0.0631

## 2 1.0553 nan 0.1000 0.0510

## 3 0.9610 nan 0.1000 0.0491

## 4 0.8846 nan 0.1000 0.0379

## 5 0.8118 nan 0.1000 0.0345

## 6 0.7602 nan 0.1000 0.0245

## 7 0.7073 nan 0.1000 0.0259

## 8 0.6631 nan 0.1000 0.0225

## 9 0.6241 nan 0.1000 0.0169

## 10 0.5903 nan 0.1000 0.0164

## 20 0.3839 nan 0.1000 0.0043

## 40 0.2482 nan 0.1000 0.0008

## 60 0.2035 nan 0.1000 -0.0009

## 80 0.1767 nan 0.1000 -0.0003

## 100 0.1626 nan 0.1000 0.0004

## 120 0.1486 nan 0.1000 -0.0009

## 140 0.1426 nan 0.1000 -0.0002

## 160 0.1389 nan 0.1000 -0.0010

## 180 0.1345 nan 0.1000 -0.0011

## 200 0.1262 nan 0.1000 -0.0007

## 220 0.1193 nan 0.1000 -0.0009

## 240 0.1166 nan 0.1000 -0.0002

## 260 0.1156 nan 0.1000 -0.0008

## 280 0.1151 nan 0.1000 -0.0015

## 300 0.1129 nan 0.1000 -0.0009

## 320 0.1111 nan 0.1000 -0.0013

## 340 0.1066 nan 0.1000 -0.0008

## 360 0.1035 nan 0.1000 -0.0016

## 380 0.1029 nan 0.1000 -0.0009

## 400 0.1000 nan 0.1000 -0.0002

## 420 0.0994 nan 0.1000 -0.0007

## 440 0.0972 nan 0.1000 -0.0006

## 460 0.0974 nan 0.1000 -0.0014

## 480 0.0961 nan 0.1000 -0.0011

## 500 0.0953 nan 0.1000 -0.0004

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1341 nan 0.1000 0.0735

## 2 1.0147 nan 0.1000 0.0594

## 3 0.9153 nan 0.1000 0.0488

## 4 0.8325 nan 0.1000 0.0409

## 5 0.7605 nan 0.1000 0.0346

## 6 0.7002 nan 0.1000 0.0284

## 7 0.6507 nan 0.1000 0.0236

## 8 0.6035 nan 0.1000 0.0231

## 9 0.5618 nan 0.1000 0.0187

## 10 0.5259 nan 0.1000 0.0148

## 20 0.3162 nan 0.1000 0.0028

## 40 0.1852 nan 0.1000 -0.0000

## 60 0.1503 nan 0.1000 -0.0000

## 80 0.1293 nan 0.1000 -0.0012

## 100 0.1066 nan 0.1000 -0.0009

## 120 0.0926 nan 0.1000 -0.0010

## 140 0.0817 nan 0.1000 -0.0011

## 160 0.0728 nan 0.1000 -0.0009

## 180 0.0664 nan 0.1000 -0.0001

## 200 0.0590 nan 0.1000 -0.0003

## 220 0.0516 nan 0.1000 -0.0004

## 240 0.0480 nan 0.1000 -0.0002

## 260 0.0440 nan 0.1000 -0.0001

## 280 0.0400 nan 0.1000 -0.0004

## 300 0.0354 nan 0.1000 -0.0003

## 320 0.0318 nan 0.1000 -0.0004

## 340 0.0286 nan 0.1000 -0.0003

## 360 0.0261 nan 0.1000 -0.0003

## 380 0.0233 nan 0.1000 -0.0002

## 400 0.0216 nan 0.1000 -0.0001

## 420 0.0196 nan 0.1000 -0.0001

## 440 0.0180 nan 0.1000 -0.0001

## 460 0.0162 nan 0.1000 -0.0001

## 480 0.0149 nan 0.1000 -0.0002

## 500 0.0137 nan 0.1000 -0.0002

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1365 nan 0.1000 0.0771

## 2 1.0119 nan 0.1000 0.0640

## 3 0.9063 nan 0.1000 0.0484

## 4 0.8232 nan 0.1000 0.0408

## 5 0.7521 nan 0.1000 0.0344

## 6 0.6930 nan 0.1000 0.0284

## 7 0.6384 nan 0.1000 0.0260

## 8 0.5884 nan 0.1000 0.0225

## 9 0.5428 nan 0.1000 0.0194

## 10 0.5065 nan 0.1000 0.0155

## 20 0.2874 nan 0.1000 0.0056

## 40 0.1529 nan 0.1000 -0.0008

## 60 0.1162 nan 0.1000 -0.0009

## 80 0.0887 nan 0.1000 -0.0001

## 100 0.0655 nan 0.1000 -0.0007

## 120 0.0539 nan 0.1000 -0.0004

## 140 0.0433 nan 0.1000 0.0000

## 160 0.0355 nan 0.1000 -0.0003

## 180 0.0282 nan 0.1000 -0.0004

## 200 0.0229 nan 0.1000 -0.0001

## 220 0.0195 nan 0.1000 -0.0002

## 240 0.0165 nan 0.1000 -0.0001

## 260 0.0143 nan 0.1000 0.0000

## 280 0.0122 nan 0.1000 -0.0002

## 300 0.0101 nan 0.1000 -0.0001

## 320 0.0086 nan 0.1000 -0.0001

## 340 0.0074 nan 0.1000 -0.0000

## 360 0.0065 nan 0.1000 -0.0001

## 380 0.0058 nan 0.1000 -0.0001

## 400 0.0048 nan 0.1000 -0.0001

## 420 0.0042 nan 0.1000 -0.0000

## 440 0.0035 nan 0.1000 -0.0000

## 460 0.0030 nan 0.1000 -0.0000

## 480 0.0025 nan 0.1000 -0.0000

## 500 0.0022 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1443 nan 0.1000 0.0686

## 2 1.0217 nan 0.1000 0.0564

## 3 0.9226 nan 0.1000 0.0481

## 4 0.8398 nan 0.1000 0.0394

## 5 0.7634 nan 0.1000 0.0355

## 6 0.6985 nan 0.1000 0.0307

## 7 0.6452 nan 0.1000 0.0234

## 8 0.5899 nan 0.1000 0.0239

## 9 0.5491 nan 0.1000 0.0182

## 10 0.5111 nan 0.1000 0.0179

## 20 0.2888 nan 0.1000 0.0043

## 40 0.1428 nan 0.1000 0.0002

## 60 0.0908 nan 0.1000 -0.0009

## 80 0.0648 nan 0.1000 -0.0009

## 100 0.0478 nan 0.1000 -0.0001

## 120 0.0383 nan 0.1000 -0.0003

## 140 0.0315 nan 0.1000 -0.0004

## 160 0.0258 nan 0.1000 -0.0004

## 180 0.0197 nan 0.1000 -0.0002

## 200 0.0155 nan 0.1000 -0.0002

## 220 0.0119 nan 0.1000 -0.0001

## 240 0.0098 nan 0.1000 -0.0002

## 260 0.0076 nan 0.1000 -0.0001

## 280 0.0060 nan 0.1000 -0.0001

## 300 0.0048 nan 0.1000 -0.0000

## 320 0.0040 nan 0.1000 -0.0000

## 340 0.0033 nan 0.1000 -0.0000

## 360 0.0027 nan 0.1000 -0.0000

## 380 0.0023 nan 0.1000 -0.0000

## 400 0.0020 nan 0.1000 -0.0000

## 420 0.0017 nan 0.1000 -0.0000

## 440 0.0014 nan 0.1000 -0.0000

## 460 0.0011 nan 0.1000 -0.0000

## 480 0.0010 nan 0.1000 -0.0000

## 500 0.0008 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1342 nan 0.1000 0.0735

## 2 1.0106 nan 0.1000 0.0598

## 3 0.9114 nan 0.1000 0.0471

## 4 0.8277 nan 0.1000 0.0376

## 5 0.7512 nan 0.1000 0.0386

## 6 0.6900 nan 0.1000 0.0307

## 7 0.6334 nan 0.1000 0.0289

## 8 0.5860 nan 0.1000 0.0208

## 9 0.5392 nan 0.1000 0.0214

## 10 0.4993 nan 0.1000 0.0174

## 20 0.2732 nan 0.1000 0.0034

## 40 0.1196 nan 0.1000 0.0007

## 60 0.0730 nan 0.1000 -0.0007

## 80 0.0508 nan 0.1000 -0.0003

## 100 0.0347 nan 0.1000 -0.0007

## 120 0.0249 nan 0.1000 -0.0003

## 140 0.0181 nan 0.1000 -0.0001

## 160 0.0148 nan 0.1000 -0.0002

## 180 0.0108 nan 0.1000 0.0000

## 200 0.0084 nan 0.1000 -0.0000

## 220 0.0065 nan 0.1000 -0.0000

## 240 0.0048 nan 0.1000 -0.0000

## 260 0.0038 nan 0.1000 -0.0000

## 280 0.0029 nan 0.1000 -0.0001

## 300 0.0021 nan 0.1000 -0.0000

## 320 0.0016 nan 0.1000 -0.0000

## 340 0.0012 nan 0.1000 -0.0000

## 360 0.0009 nan 0.1000 -0.0000

## 380 0.0007 nan 0.1000 -0.0000

## 400 0.0006 nan 0.1000 -0.0000

## 420 0.0004 nan 0.1000 -0.0000

## 440 0.0004 nan 0.1000 -0.0000

## 460 0.0003 nan 0.1000 -0.0000

## 480 0.0002 nan 0.1000 -0.0000

## 500 0.0002 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1350 nan 0.1000 0.0694

## 2 1.0050 nan 0.1000 0.0577

## 3 0.8994 nan 0.1000 0.0495

## 4 0.8119 nan 0.1000 0.0426

## 5 0.7375 nan 0.1000 0.0339

## 6 0.6715 nan 0.1000 0.0317

## 7 0.6141 nan 0.1000 0.0227

## 8 0.5620 nan 0.1000 0.0233

## 9 0.5169 nan 0.1000 0.0189

## 10 0.4821 nan 0.1000 0.0141

## 20 0.2603 nan 0.1000 0.0030

## 40 0.1199 nan 0.1000 -0.0004

## 60 0.0717 nan 0.1000 -0.0008

## 80 0.0460 nan 0.1000 -0.0003

## 100 0.0302 nan 0.1000 -0.0000

## 120 0.0211 nan 0.1000 -0.0002

## 140 0.0151 nan 0.1000 -0.0001

## 160 0.0103 nan 0.1000 -0.0001

## 180 0.0076 nan 0.1000 -0.0001

## 200 0.0054 nan 0.1000 -0.0000

## 220 0.0039 nan 0.1000 -0.0000

## 240 0.0030 nan 0.1000 -0.0000

## 260 0.0023 nan 0.1000 -0.0000

## 280 0.0018 nan 0.1000 -0.0000

## 300 0.0015 nan 0.1000 -0.0000

## 320 0.0010 nan 0.1000 -0.0000

## 340 0.0008 nan 0.1000 -0.0000

## 360 0.0006 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 0.0000

## 400 0.0004 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1295 nan 0.1000 0.0729

## 2 1.0012 nan 0.1000 0.0631

## 3 0.9023 nan 0.1000 0.0466

## 4 0.8165 nan 0.1000 0.0402

## 5 0.7436 nan 0.1000 0.0366

## 6 0.6826 nan 0.1000 0.0285

## 7 0.6324 nan 0.1000 0.0207

## 8 0.5845 nan 0.1000 0.0211

## 9 0.5399 nan 0.1000 0.0185

## 10 0.5006 nan 0.1000 0.0147

## 20 0.2691 nan 0.1000 0.0029

## 40 0.1089 nan 0.1000 -0.0010

## 60 0.0600 nan 0.1000 -0.0004

## 80 0.0380 nan 0.1000 -0.0007

## 100 0.0255 nan 0.1000 -0.0004

## 120 0.0172 nan 0.1000 -0.0004

## 140 0.0126 nan 0.1000 -0.0001

## 160 0.0085 nan 0.1000 -0.0001

## 180 0.0054 nan 0.1000 -0.0001

## 200 0.0039 nan 0.1000 -0.0001

## 220 0.0028 nan 0.1000 -0.0000

## 240 0.0020 nan 0.1000 -0.0000

## 260 0.0014 nan 0.1000 -0.0000

## 280 0.0012 nan 0.1000 -0.0000

## 300 0.0009 nan 0.1000 -0.0000

## 320 0.0008 nan 0.1000 -0.0000

## 340 0.0006 nan 0.1000 0.0000

## 360 0.0005 nan 0.1000 -0.0000

## 380 0.0004 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1288 nan 0.1000 0.0711

## 2 1.0064 nan 0.1000 0.0595

## 3 0.9036 nan 0.1000 0.0466

## 4 0.8216 nan 0.1000 0.0395

## 5 0.7497 nan 0.1000 0.0338

## 6 0.6853 nan 0.1000 0.0284

## 7 0.6341 nan 0.1000 0.0236

## 8 0.5861 nan 0.1000 0.0214

## 9 0.5443 nan 0.1000 0.0190

## 10 0.5053 nan 0.1000 0.0170

## 20 0.2653 nan 0.1000 0.0067

## 40 0.1101 nan 0.1000 0.0014

## 60 0.0583 nan 0.1000 -0.0004

## 80 0.0371 nan 0.1000 -0.0003

## 100 0.0274 nan 0.1000 -0.0003

## 120 0.0179 nan 0.1000 -0.0003

## 140 0.0133 nan 0.1000 -0.0002

## 160 0.0102 nan 0.1000 -0.0001

## 180 0.0073 nan 0.1000 -0.0002

## 200 0.0051 nan 0.1000 -0.0000

## 220 0.0043 nan 0.1000 -0.0001

## 240 0.0031 nan 0.1000 -0.0000

## 260 0.0024 nan 0.1000 -0.0000

## 280 0.0021 nan 0.1000 -0.0000

## 300 0.0017 nan 0.1000 -0.0001

## 320 0.0012 nan 0.1000 -0.0000

## 340 0.0010 nan 0.1000 -0.0000

## 360 0.0008 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 -0.0000

## 400 0.0004 nan 0.1000 -0.0000

## 420 0.0004 nan 0.1000 -0.0000

## 440 0.0003 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0002 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1353 nan 0.1000 0.0754

## 2 1.0182 nan 0.1000 0.0578

## 3 0.9152 nan 0.1000 0.0484

## 4 0.8254 nan 0.1000 0.0396

## 5 0.7535 nan 0.1000 0.0332

## 6 0.6910 nan 0.1000 0.0289

## 7 0.6294 nan 0.1000 0.0286

## 8 0.5823 nan 0.1000 0.0216

## 9 0.5372 nan 0.1000 0.0188

## 10 0.4969 nan 0.1000 0.0176

## 20 0.2674 nan 0.1000 0.0038

## 40 0.1080 nan 0.1000 0.0004

## 60 0.0596 nan 0.1000 -0.0003

## 80 0.0413 nan 0.1000 -0.0005

## 100 0.0250 nan 0.1000 -0.0003

## 120 0.0189 nan 0.1000 -0.0003

## 140 0.0142 nan 0.1000 -0.0003

## 160 0.0100 nan 0.1000 -0.0003

## 180 0.0068 nan 0.1000 -0.0003

## 200 0.0043 nan 0.1000 -0.0001

## 220 0.0028 nan 0.1000 -0.0000

## 240 0.0023 nan 0.1000 -0.0001

## 260 0.0016 nan 0.1000 -0.0000

## 280 0.0015 nan 0.1000 -0.0001

## 300 0.0012 nan 0.1000 -0.0001

## 320 0.0010 nan 0.1000 -0.0000

## 340 0.0010 nan 0.1000 -0.0001

## 360 0.0007 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 -0.0000

## 400 0.0004 nan 0.1000 0.0000

## 420 0.0003 nan 0.1000 0.0000

## 440 0.0002 nan 0.1000 0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1309 nan 0.1000 0.0724

## 2 1.0101 nan 0.1000 0.0554

## 3 0.9140 nan 0.1000 0.0448

## 4 0.8287 nan 0.1000 0.0393

## 5 0.7571 nan 0.1000 0.0311

## 6 0.6957 nan 0.1000 0.0269

## 7 0.6418 nan 0.1000 0.0244

## 8 0.5889 nan 0.1000 0.0223

## 9 0.5438 nan 0.1000 0.0203

## 10 0.5068 nan 0.1000 0.0163

## 20 0.2685 nan 0.1000 0.0058

## 40 0.1141 nan 0.1000 -0.0003

## 60 0.0593 nan 0.1000 -0.0003

## 80 0.0346 nan 0.1000 -0.0002

## 100 0.0226 nan 0.1000 -0.0005

## 120 0.0138 nan 0.1000 -0.0002

## 140 0.0095 nan 0.1000 -0.0002

## 160 0.0066 nan 0.1000 -0.0001

## 180 0.0050 nan 0.1000 0.0000

## 200 0.0032 nan 0.1000 -0.0000

## 220 0.0024 nan 0.1000 -0.0001

## 240 0.0021 nan 0.1000 -0.0001

## 260 0.0014 nan 0.1000 -0.0000

## 280 0.0012 nan 0.1000 -0.0001

## 300 0.0009 nan 0.1000 -0.0000

## 320 0.0007 nan 0.1000 -0.0000

## 340 0.0005 nan 0.1000 -0.0000

## 360 0.0005 nan 0.1000 -0.0000

## 380 0.0003 nan 0.1000 -0.0000

## 400 0.0002 nan 0.1000 -0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1529 nan 0.1000 0.0627

## 2 1.0422 nan 0.1000 0.0535

## 3 0.9454 nan 0.1000 0.0485

## 4 0.8647 nan 0.1000 0.0404

## 5 0.7992 nan 0.1000 0.0333

## 6 0.7419 nan 0.1000 0.0277

## 7 0.6939 nan 0.1000 0.0234

## 8 0.6501 nan 0.1000 0.0194

## 9 0.6073 nan 0.1000 0.0196

## 10 0.5718 nan 0.1000 0.0159

## 20 0.3715 nan 0.1000 0.0055

## 40 0.2363 nan 0.1000 -0.0002

## 60 0.1844 nan 0.1000 0.0010

## 80 0.1610 nan 0.1000 -0.0006

## 100 0.1447 nan 0.1000 -0.0011

## 120 0.1332 nan 0.1000 -0.0023

## 140 0.1238 nan 0.1000 -0.0004

## 160 0.1191 nan 0.1000 -0.0006

## 180 0.1098 nan 0.1000 -0.0008

## 200 0.1033 nan 0.1000 -0.0010

## 220 0.0996 nan 0.1000 -0.0010

## 240 0.0944 nan 0.1000 -0.0007

## 260 0.0917 nan 0.1000 -0.0009

## 280 0.0882 nan 0.1000 -0.0005

## 300 0.0846 nan 0.1000 -0.0008

## 320 0.0837 nan 0.1000 -0.0003

## 340 0.0824 nan 0.1000 -0.0008

## 360 0.0803 nan 0.1000 -0.0005

## 380 0.0788 nan 0.1000 -0.0008

## 400 0.0775 nan 0.1000 -0.0011

## 420 0.0755 nan 0.1000 -0.0011

## 440 0.0749 nan 0.1000 -0.0007

## 460 0.0742 nan 0.1000 -0.0002

## 480 0.0727 nan 0.1000 -0.0004

## 500 0.0719 nan 0.1000 -0.0003

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1456 nan 0.1000 0.0697

## 2 1.0206 nan 0.1000 0.0677

## 3 0.9204 nan 0.1000 0.0506

## 4 0.8354 nan 0.1000 0.0393

## 5 0.7583 nan 0.1000 0.0349

## 6 0.6986 nan 0.1000 0.0282

## 7 0.6396 nan 0.1000 0.0269

## 8 0.5938 nan 0.1000 0.0225

## 9 0.5520 nan 0.1000 0.0188

## 10 0.5137 nan 0.1000 0.0158

## 20 0.2915 nan 0.1000 0.0064

## 40 0.1801 nan 0.1000 -0.0004

## 60 0.1383 nan 0.1000 -0.0005

## 80 0.1124 nan 0.1000 -0.0012

## 100 0.0907 nan 0.1000 -0.0005

## 120 0.0772 nan 0.1000 -0.0005

## 140 0.0662 nan 0.1000 -0.0007

## 160 0.0567 nan 0.1000 -0.0007

## 180 0.0497 nan 0.1000 -0.0005

## 200 0.0447 nan 0.1000 -0.0004

## 220 0.0395 nan 0.1000 -0.0002

## 240 0.0353 nan 0.1000 -0.0002

## 260 0.0334 nan 0.1000 -0.0007

## 280 0.0294 nan 0.1000 -0.0001

## 300 0.0273 nan 0.1000 -0.0004

## 320 0.0245 nan 0.1000 -0.0000

## 340 0.0221 nan 0.1000 -0.0002

## 360 0.0202 nan 0.1000 -0.0003

## 380 0.0186 nan 0.1000 -0.0003

## 400 0.0169 nan 0.1000 -0.0003

## 420 0.0158 nan 0.1000 -0.0002

## 440 0.0147 nan 0.1000 -0.0001

## 460 0.0133 nan 0.1000 -0.0001

## 480 0.0121 nan 0.1000 -0.0001

## 500 0.0109 nan 0.1000 -0.0001

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1408 nan 0.1000 0.0641

## 2 1.0134 nan 0.1000 0.0611

## 3 0.9112 nan 0.1000 0.0464

## 4 0.8236 nan 0.1000 0.0396

## 5 0.7548 nan 0.1000 0.0329

## 6 0.6926 nan 0.1000 0.0305

## 7 0.6403 nan 0.1000 0.0239

## 8 0.5918 nan 0.1000 0.0219

## 9 0.5494 nan 0.1000 0.0190

## 10 0.5128 nan 0.1000 0.0175

## 20 0.2863 nan 0.1000 0.0054

## 40 0.1454 nan 0.1000 0.0003

## 60 0.0979 nan 0.1000 0.0003

## 80 0.0733 nan 0.1000 -0.0006

## 100 0.0575 nan 0.1000 -0.0004

## 120 0.0460 nan 0.1000 -0.0000

## 140 0.0362 nan 0.1000 -0.0002

## 160 0.0291 nan 0.1000 -0.0002

## 180 0.0257 nan 0.1000 -0.0005

## 200 0.0212 nan 0.1000 -0.0001

## 220 0.0182 nan 0.1000 -0.0001

## 240 0.0155 nan 0.1000 -0.0001

## 260 0.0128 nan 0.1000 -0.0001

## 280 0.0112 nan 0.1000 -0.0001

## 300 0.0092 nan 0.1000 -0.0002

## 320 0.0079 nan 0.1000 -0.0000

## 340 0.0068 nan 0.1000 -0.0001

## 360 0.0059 nan 0.1000 -0.0000

## 380 0.0052 nan 0.1000 -0.0000

## 400 0.0044 nan 0.1000 -0.0000

## 420 0.0037 nan 0.1000 -0.0000

## 440 0.0031 nan 0.1000 -0.0000

## 460 0.0027 nan 0.1000 -0.0000

## 480 0.0023 nan 0.1000 -0.0000

## 500 0.0020 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1331 nan 0.1000 0.0773

## 2 1.0115 nan 0.1000 0.0621

## 3 0.9083 nan 0.1000 0.0462

## 4 0.8296 nan 0.1000 0.0383

## 5 0.7528 nan 0.1000 0.0336

## 6 0.6892 nan 0.1000 0.0276

## 7 0.6321 nan 0.1000 0.0264

## 8 0.5801 nan 0.1000 0.0243

## 9 0.5341 nan 0.1000 0.0199

## 10 0.4957 nan 0.1000 0.0182

## 20 0.2819 nan 0.1000 0.0022

## 40 0.1394 nan 0.1000 0.0002

## 60 0.0964 nan 0.1000 -0.0000

## 80 0.0651 nan 0.1000 -0.0006

## 100 0.0470 nan 0.1000 -0.0007

## 120 0.0363 nan 0.1000 -0.0002

## 140 0.0293 nan 0.1000 -0.0004

## 160 0.0220 nan 0.1000 -0.0001

## 180 0.0178 nan 0.1000 -0.0001

## 200 0.0131 nan 0.1000 -0.0001

## 220 0.0102 nan 0.1000 -0.0001

## 240 0.0081 nan 0.1000 -0.0001

## 260 0.0071 nan 0.1000 -0.0001

## 280 0.0058 nan 0.1000 -0.0001

## 300 0.0048 nan 0.1000 -0.0001

## 320 0.0038 nan 0.1000 -0.0000

## 340 0.0031 nan 0.1000 -0.0000

## 360 0.0025 nan 0.1000 -0.0000

## 380 0.0019 nan 0.1000 -0.0000

## 400 0.0015 nan 0.1000 -0.0000

## 420 0.0012 nan 0.1000 -0.0000

## 440 0.0009 nan 0.1000 -0.0000

## 460 0.0008 nan 0.1000 -0.0000

## 480 0.0006 nan 0.1000 -0.0000

## 500 0.0005 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1344 nan 0.1000 0.0733

## 2 1.0068 nan 0.1000 0.0618

## 3 0.9027 nan 0.1000 0.0506

## 4 0.8130 nan 0.1000 0.0403

## 5 0.7384 nan 0.1000 0.0360

## 6 0.6727 nan 0.1000 0.0301

## 7 0.6138 nan 0.1000 0.0271

## 8 0.5677 nan 0.1000 0.0197

## 9 0.5251 nan 0.1000 0.0179

## 10 0.4852 nan 0.1000 0.0189

## 20 0.2666 nan 0.1000 0.0063

## 40 0.1235 nan 0.1000 0.0005

## 60 0.0726 nan 0.1000 -0.0012

## 80 0.0447 nan 0.1000 -0.0005

## 100 0.0312 nan 0.1000 0.0004

## 120 0.0227 nan 0.1000 -0.0004

## 140 0.0171 nan 0.1000 -0.0001

## 160 0.0126 nan 0.1000 -0.0000

## 180 0.0090 nan 0.1000 -0.0001

## 200 0.0069 nan 0.1000 -0.0000

## 220 0.0052 nan 0.1000 -0.0000

## 240 0.0038 nan 0.1000 -0.0001

## 260 0.0029 nan 0.1000 -0.0000

## 280 0.0022 nan 0.1000 -0.0001

## 300 0.0017 nan 0.1000 -0.0000

## 320 0.0013 nan 0.1000 -0.0000

## 340 0.0010 nan 0.1000 -0.0000

## 360 0.0007 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 -0.0000

## 400 0.0004 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1342 nan 0.1000 0.0749

## 2 1.0105 nan 0.1000 0.0593

## 3 0.9092 nan 0.1000 0.0485

## 4 0.8211 nan 0.1000 0.0415

## 5 0.7409 nan 0.1000 0.0383

## 6 0.6751 nan 0.1000 0.0316

## 7 0.6194 nan 0.1000 0.0272

## 8 0.5717 nan 0.1000 0.0219

## 9 0.5278 nan 0.1000 0.0193

## 10 0.4933 nan 0.1000 0.0161

## 20 0.2610 nan 0.1000 0.0042

## 40 0.1180 nan 0.1000 -0.0014

## 60 0.0707 nan 0.1000 0.0003

## 80 0.0417 nan 0.1000 -0.0004

## 100 0.0278 nan 0.1000 -0.0002

## 120 0.0194 nan 0.1000 -0.0004

## 140 0.0132 nan 0.1000 -0.0003

## 160 0.0090 nan 0.1000 -0.0001

## 180 0.0073 nan 0.1000 -0.0002

## 200 0.0054 nan 0.1000 -0.0001

## 220 0.0040 nan 0.1000 -0.0001

## 240 0.0031 nan 0.1000 -0.0000

## 260 0.0023 nan 0.1000 -0.0001

## 280 0.0016 nan 0.1000 -0.0000

## 300 0.0011 nan 0.1000 -0.0000

## 320 0.0009 nan 0.1000 -0.0000

## 340 0.0008 nan 0.1000 -0.0000

## 360 0.0006 nan 0.1000 -0.0000

## 380 0.0004 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1331 nan 0.1000 0.0715

## 2 1.0134 nan 0.1000 0.0589

## 3 0.9154 nan 0.1000 0.0447

## 4 0.8226 nan 0.1000 0.0399

## 5 0.7490 nan 0.1000 0.0339

## 6 0.6845 nan 0.1000 0.0295

## 7 0.6301 nan 0.1000 0.0246

## 8 0.5820 nan 0.1000 0.0215

## 9 0.5374 nan 0.1000 0.0210

## 10 0.4973 nan 0.1000 0.0172

## 20 0.2622 nan 0.1000 0.0058

## 40 0.1177 nan 0.1000 0.0003

## 60 0.0666 nan 0.1000 -0.0000

## 80 0.0432 nan 0.1000 -0.0008

## 100 0.0294 nan 0.1000 -0.0005

## 120 0.0182 nan 0.1000 -0.0002

## 140 0.0135 nan 0.1000 -0.0003

## 160 0.0086 nan 0.1000 -0.0001

## 180 0.0062 nan 0.1000 -0.0002

## 200 0.0041 nan 0.1000 -0.0001

## 220 0.0034 nan 0.1000 -0.0000

## 240 0.0026 nan 0.1000 -0.0000

## 260 0.0018 nan 0.1000 -0.0000

## 280 0.0014 nan 0.1000 -0.0000

## 300 0.0010 nan 0.1000 -0.0000

## 320 0.0008 nan 0.1000 -0.0000

## 340 0.0006 nan 0.1000 -0.0000

## 360 0.0004 nan 0.1000 -0.0000

## 380 0.0005 nan 0.1000 -0.0000

## 400 0.0003 nan 0.1000 0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0004 nan 0.1000 -0.0000

## 460 0.0003 nan 0.1000 -0.0000

## 480 0.0003 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1238 nan 0.1000 0.0828

## 2 0.9975 nan 0.1000 0.0631

## 3 0.8940 nan 0.1000 0.0481

## 4 0.8043 nan 0.1000 0.0428

## 5 0.7331 nan 0.1000 0.0340

## 6 0.6656 nan 0.1000 0.0311

## 7 0.6098 nan 0.1000 0.0245

## 8 0.5658 nan 0.1000 0.0184

## 9 0.5238 nan 0.1000 0.0195

## 10 0.4835 nan 0.1000 0.0187

## 20 0.2530 nan 0.1000 0.0051

## 40 0.0976 nan 0.1000 0.0005

## 60 0.0491 nan 0.1000 -0.0006

## 80 0.0294 nan 0.1000 -0.0001

## 100 0.0203 nan 0.1000 -0.0002

## 120 0.0145 nan 0.1000 -0.0002

## 140 0.0103 nan 0.1000 -0.0000

## 160 0.0074 nan 0.1000 -0.0002

## 180 0.0047 nan 0.1000 -0.0001

## 200 0.0030 nan 0.1000 -0.0000

## 220 0.0024 nan 0.1000 -0.0000

## 240 0.0018 nan 0.1000 -0.0001

## 260 0.0013 nan 0.1000 -0.0000

## 280 0.0009 nan 0.1000 -0.0000

## 300 0.0008 nan 0.1000 -0.0000

## 320 0.0006 nan 0.1000 0.0000

## 340 0.0004 nan 0.1000 -0.0000

## 360 0.0003 nan 0.1000 -0.0000

## 380 0.0002 nan 0.1000 -0.0000

## 400 0.0002 nan 0.1000 0.0000

## 420 0.0002 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1292 nan 0.1000 0.0808

## 2 1.0022 nan 0.1000 0.0586

## 3 0.9062 nan 0.1000 0.0442

## 4 0.8209 nan 0.1000 0.0405

## 5 0.7440 nan 0.1000 0.0389

## 6 0.6795 nan 0.1000 0.0309

## 7 0.6248 nan 0.1000 0.0254

## 8 0.5780 nan 0.1000 0.0204

## 9 0.5304 nan 0.1000 0.0233

## 10 0.4938 nan 0.1000 0.0153

## 20 0.2587 nan 0.1000 0.0049

## 40 0.1005 nan 0.1000 0.0003

## 60 0.0533 nan 0.1000 -0.0006

## 80 0.0330 nan 0.1000 -0.0005

## 100 0.0228 nan 0.1000 -0.0004

## 120 0.0142 nan 0.1000 -0.0002

## 140 0.0119 nan 0.1000 -0.0003

## 160 0.0085 nan 0.1000 0.0000

## 180 0.0064 nan 0.1000 -0.0002

## 200 0.0044 nan 0.1000 -0.0000

## 220 0.0030 nan 0.1000 -0.0001

## 240 0.0021 nan 0.1000 -0.0000

## 260 0.0015 nan 0.1000 -0.0000

## 280 0.0012 nan 0.1000 -0.0000

## 300 0.0010 nan 0.1000 -0.0000

## 320 0.0007 nan 0.1000 -0.0000

## 340 0.0005 nan 0.1000 0.0000

## 360 0.0003 nan 0.1000 -0.0000

## 380 0.0002 nan 0.1000 -0.0000

## 400 0.0002 nan 0.1000 -0.0000

## 420 0.0001 nan 0.1000 -0.0000

## 440 0.0001 nan 0.1000 -0.0000

## 460 0.0001 nan 0.1000 -0.0000

## 480 0.0000 nan 0.1000 -0.0000

## 500 0.0000 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1386 nan 0.1000 0.0720

## 2 1.0105 nan 0.1000 0.0640

## 3 0.9058 nan 0.1000 0.0494

## 4 0.8200 nan 0.1000 0.0398

## 5 0.7404 nan 0.1000 0.0357

## 6 0.6755 nan 0.1000 0.0294

## 7 0.6220 nan 0.1000 0.0244

## 8 0.5690 nan 0.1000 0.0249

## 9 0.5253 nan 0.1000 0.0178

## 10 0.4900 nan 0.1000 0.0156

## 20 0.2620 nan 0.1000 0.0050

## 40 0.1074 nan 0.1000 -0.0005

## 60 0.0537 nan 0.1000 -0.0009

## 80 0.0348 nan 0.1000 -0.0001

## 100 0.0222 nan 0.1000 -0.0004

## 120 0.0158 nan 0.1000 -0.0002

## 140 0.0109 nan 0.1000 -0.0003

## 160 0.0084 nan 0.1000 -0.0002

## 180 0.0067 nan 0.1000 -0.0001

## 200 0.0060 nan 0.1000 -0.0002

## 220 0.0040 nan 0.1000 -0.0000

## 240 0.0033 nan 0.1000 -0.0001

## 260 0.0026 nan 0.1000 -0.0000

## 280 0.0017 nan 0.1000 -0.0000

## 300 0.0013 nan 0.1000 -0.0000

## 320 0.0011 nan 0.1000 -0.0000

## 340 0.0009 nan 0.1000 -0.0000

## 360 0.0008 nan 0.1000 -0.0000

## 380 0.0006 nan 0.1000 -0.0000

## 400 0.0005 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0003 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0002 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1522 nan 0.1000 0.0678

## 2 1.0417 nan 0.1000 0.0503

## 3 0.9464 nan 0.1000 0.0455

## 4 0.8631 nan 0.1000 0.0418

## 5 0.7950 nan 0.1000 0.0337

## 6 0.7381 nan 0.1000 0.0270

## 7 0.6856 nan 0.1000 0.0255

## 8 0.6401 nan 0.1000 0.0194

## 9 0.6049 nan 0.1000 0.0181

## 10 0.5647 nan 0.1000 0.0180

## 20 0.3614 nan 0.1000 0.0060

## 40 0.2206 nan 0.1000 0.0012

## 60 0.1815 nan 0.1000 -0.0008

## 80 0.1564 nan 0.1000 -0.0007

## 100 0.1428 nan 0.1000 -0.0006

## 120 0.1333 nan 0.1000 -0.0008

## 140 0.1276 nan 0.1000 -0.0010

## 160 0.1182 nan 0.1000 -0.0008

## 180 0.1096 nan 0.1000 -0.0001

## 200 0.1060 nan 0.1000 -0.0009

## 220 0.1010 nan 0.1000 -0.0007

## 240 0.0976 nan 0.1000 -0.0005

## 260 0.0956 nan 0.1000 -0.0003

## 280 0.0942 nan 0.1000 -0.0001

## 300 0.0911 nan 0.1000 -0.0007

## 320 0.0882 nan 0.1000 -0.0005

## 340 0.0870 nan 0.1000 -0.0006

## 360 0.0854 nan 0.1000 -0.0007

## 380 0.0841 nan 0.1000 -0.0007

## 400 0.0828 nan 0.1000 -0.0007

## 420 0.0814 nan 0.1000 -0.0006

## 440 0.0803 nan 0.1000 -0.0003

## 460 0.0782 nan 0.1000 -0.0005

## 480 0.0763 nan 0.1000 -0.0004

## 500 0.0763 nan 0.1000 -0.0011

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1353 nan 0.1000 0.0730

## 2 1.0175 nan 0.1000 0.0620

## 3 0.9192 nan 0.1000 0.0481

## 4 0.8336 nan 0.1000 0.0414

## 5 0.7661 nan 0.1000 0.0334

## 6 0.7064 nan 0.1000 0.0265

## 7 0.6485 nan 0.1000 0.0275

## 8 0.5948 nan 0.1000 0.0240

## 9 0.5526 nan 0.1000 0.0195

## 10 0.5177 nan 0.1000 0.0157

## 20 0.2948 nan 0.1000 0.0053

## 40 0.1691 nan 0.1000 -0.0021

## 60 0.1304 nan 0.1000 -0.0006

## 80 0.1128 nan 0.1000 -0.0007

## 100 0.0921 nan 0.1000 -0.0009

## 120 0.0800 nan 0.1000 -0.0004

## 140 0.0682 nan 0.1000 -0.0002

## 160 0.0598 nan 0.1000 -0.0004

## 180 0.0556 nan 0.1000 -0.0006

## 200 0.0489 nan 0.1000 -0.0005

## 220 0.0437 nan 0.1000 -0.0001

## 240 0.0416 nan 0.1000 -0.0003

## 260 0.0377 nan 0.1000 -0.0004

## 280 0.0325 nan 0.1000 -0.0002

## 300 0.0307 nan 0.1000 -0.0002

## 320 0.0280 nan 0.1000 -0.0003

## 340 0.0260 nan 0.1000 -0.0003

## 360 0.0242 nan 0.1000 -0.0000

## 380 0.0215 nan 0.1000 -0.0002

## 400 0.0195 nan 0.1000 -0.0002

## 420 0.0178 nan 0.1000 -0.0001

## 440 0.0166 nan 0.1000 -0.0002

## 460 0.0151 nan 0.1000 -0.0000

## 480 0.0137 nan 0.1000 -0.0000

## 500 0.0127 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1341 nan 0.1000 0.0725

## 2 1.0093 nan 0.1000 0.0586

## 3 0.9047 nan 0.1000 0.0492

## 4 0.8189 nan 0.1000 0.0427

## 5 0.7469 nan 0.1000 0.0361

## 6 0.6816 nan 0.1000 0.0331

## 7 0.6232 nan 0.1000 0.0275

## 8 0.5757 nan 0.1000 0.0221

## 9 0.5318 nan 0.1000 0.0190

## 10 0.4966 nan 0.1000 0.0158

## 20 0.2699 nan 0.1000 0.0055

## 40 0.1396 nan 0.1000 -0.0002

## 60 0.0968 nan 0.1000 0.0002

## 80 0.0775 nan 0.1000 -0.0006

## 100 0.0617 nan 0.1000 -0.0008

## 120 0.0482 nan 0.1000 -0.0009

## 140 0.0378 nan 0.1000 -0.0003

## 160 0.0305 nan 0.1000 -0.0004

## 180 0.0265 nan 0.1000 -0.0001

## 200 0.0219 nan 0.1000 -0.0003

## 220 0.0176 nan 0.1000 -0.0001

## 240 0.0145 nan 0.1000 -0.0001

## 260 0.0122 nan 0.1000 -0.0001

## 280 0.0105 nan 0.1000 -0.0001

## 300 0.0091 nan 0.1000 -0.0001

## 320 0.0075 nan 0.1000 -0.0001

## 340 0.0066 nan 0.1000 -0.0000

## 360 0.0060 nan 0.1000 -0.0001

## 380 0.0051 nan 0.1000 -0.0001

## 400 0.0043 nan 0.1000 -0.0001

## 420 0.0036 nan 0.1000 -0.0000

## 440 0.0031 nan 0.1000 -0.0000

## 460 0.0028 nan 0.1000 -0.0000

## 480 0.0023 nan 0.1000 -0.0000

## 500 0.0021 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1324 nan 0.1000 0.0750

## 2 1.0074 nan 0.1000 0.0583

## 3 0.9005 nan 0.1000 0.0509

## 4 0.8152 nan 0.1000 0.0404

## 5 0.7381 nan 0.1000 0.0361

## 6 0.6761 nan 0.1000 0.0296

## 7 0.6209 nan 0.1000 0.0249

## 8 0.5718 nan 0.1000 0.0221

## 9 0.5315 nan 0.1000 0.0162

## 10 0.4942 nan 0.1000 0.0164

## 20 0.2736 nan 0.1000 0.0041

## 40 0.1291 nan 0.1000 0.0010

## 60 0.0841 nan 0.1000 -0.0013

## 80 0.0595 nan 0.1000 -0.0007

## 100 0.0434 nan 0.1000 -0.0004

## 120 0.0343 nan 0.1000 -0.0005

## 140 0.0267 nan 0.1000 -0.0002

## 160 0.0209 nan 0.1000 -0.0004

## 180 0.0169 nan 0.1000 -0.0003

## 200 0.0134 nan 0.1000 -0.0002

## 220 0.0107 nan 0.1000 -0.0001

## 240 0.0086 nan 0.1000 -0.0001

## 260 0.0066 nan 0.1000 -0.0001

## 280 0.0054 nan 0.1000 -0.0000

## 300 0.0044 nan 0.1000 -0.0000

## 320 0.0035 nan 0.1000 -0.0000

## 340 0.0028 nan 0.1000 -0.0000

## 360 0.0023 nan 0.1000 -0.0000

## 380 0.0018 nan 0.1000 -0.0000

## 400 0.0015 nan 0.1000 -0.0000

## 420 0.0012 nan 0.1000 -0.0000

## 440 0.0011 nan 0.1000 -0.0000

## 460 0.0008 nan 0.1000 -0.0000

## 480 0.0007 nan 0.1000 -0.0000

## 500 0.0005 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1259 nan 0.1000 0.0782

## 2 1.0025 nan 0.1000 0.0620

## 3 0.9038 nan 0.1000 0.0460

## 4 0.8143 nan 0.1000 0.0411

## 5 0.7391 nan 0.1000 0.0344

## 6 0.6730 nan 0.1000 0.0304

## 7 0.6182 nan 0.1000 0.0256

## 8 0.5655 nan 0.1000 0.0251

## 9 0.5215 nan 0.1000 0.0178

## 10 0.4832 nan 0.1000 0.0189

## 20 0.2554 nan 0.1000 0.0048

## 40 0.1142 nan 0.1000 0.0000

## 60 0.0705 nan 0.1000 -0.0009

## 80 0.0507 nan 0.1000 -0.0006

## 100 0.0357 nan 0.1000 0.0002

## 120 0.0252 nan 0.1000 -0.0003

## 140 0.0187 nan 0.1000 -0.0003

## 160 0.0130 nan 0.1000 -0.0001

## 180 0.0113 nan 0.1000 -0.0004

## 200 0.0080 nan 0.1000 -0.0001

## 220 0.0064 nan 0.1000 -0.0001

## 240 0.0046 nan 0.1000 -0.0000

## 260 0.0036 nan 0.1000 -0.0000

## 280 0.0028 nan 0.1000 -0.0000

## 300 0.0023 nan 0.1000 -0.0000

## 320 0.0019 nan 0.1000 -0.0000

## 340 0.0015 nan 0.1000 -0.0000

## 360 0.0012 nan 0.1000 -0.0000

## 380 0.0009 nan 0.1000 -0.0000

## 400 0.0007 nan 0.1000 -0.0000

## 420 0.0006 nan 0.1000 -0.0000

## 440 0.0004 nan 0.1000 -0.0000

## 460 0.0003 nan 0.1000 -0.0000

## 480 0.0003 nan 0.1000 -0.0000

## 500 0.0002 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1276 nan 0.1000 0.0761

## 2 1.0018 nan 0.1000 0.0624

## 3 0.8973 nan 0.1000 0.0484

## 4 0.8122 nan 0.1000 0.0385

## 5 0.7340 nan 0.1000 0.0375

## 6 0.6700 nan 0.1000 0.0319

## 7 0.6140 nan 0.1000 0.0262

## 8 0.5631 nan 0.1000 0.0236

## 9 0.5209 nan 0.1000 0.0197

## 10 0.4820 nan 0.1000 0.0174

## 20 0.2584 nan 0.1000 0.0047

## 40 0.1128 nan 0.1000 -0.0005

## 60 0.0675 nan 0.1000 -0.0003

## 80 0.0420 nan 0.1000 -0.0007

## 100 0.0283 nan 0.1000 -0.0004

## 120 0.0200 nan 0.1000 -0.0003

## 140 0.0142 nan 0.1000 -0.0000

## 160 0.0100 nan 0.1000 -0.0001

## 180 0.0076 nan 0.1000 -0.0001

## 200 0.0058 nan 0.1000 -0.0000

## 220 0.0042 nan 0.1000 -0.0000

## 240 0.0030 nan 0.1000 -0.0000

## 260 0.0022 nan 0.1000 -0.0000

## 280 0.0017 nan 0.1000 -0.0000

## 300 0.0015 nan 0.1000 -0.0000

## 320 0.0013 nan 0.1000 -0.0000

## 340 0.0010 nan 0.1000 -0.0000

## 360 0.0009 nan 0.1000 -0.0000

## 380 0.0006 nan 0.1000 -0.0000

## 400 0.0004 nan 0.1000 -0.0000

## 420 0.0004 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1289 nan 0.1000 0.0729

## 2 1.0046 nan 0.1000 0.0568

## 3 0.9031 nan 0.1000 0.0481

## 4 0.8149 nan 0.1000 0.0440

## 5 0.7401 nan 0.1000 0.0356

## 6 0.6762 nan 0.1000 0.0295

## 7 0.6175 nan 0.1000 0.0265

## 8 0.5676 nan 0.1000 0.0197

## 9 0.5274 nan 0.1000 0.0161

## 10 0.4885 nan 0.1000 0.0152

## 20 0.2634 nan 0.1000 0.0053

## 40 0.1127 nan 0.1000 -0.0009

## 60 0.0617 nan 0.1000 -0.0014

## 80 0.0409 nan 0.1000 -0.0011

## 100 0.0279 nan 0.1000 -0.0001

## 120 0.0180 nan 0.1000 -0.0003

## 140 0.0118 nan 0.1000 -0.0001

## 160 0.0088 nan 0.1000 -0.0000

## 180 0.0066 nan 0.1000 -0.0001

## 200 0.0053 nan 0.1000 -0.0001

## 220 0.0039 nan 0.1000 -0.0001

## 240 0.0029 nan 0.1000 0.0000

## 260 0.0023 nan 0.1000 -0.0000

## 280 0.0017 nan 0.1000 -0.0000

## 300 0.0012 nan 0.1000 -0.0000

## 320 0.0009 nan 0.1000 -0.0000

## 340 0.0007 nan 0.1000 -0.0000

## 360 0.0005 nan 0.1000 -0.0000

## 380 0.0004 nan 0.1000 0.0000

## 400 0.0003 nan 0.1000 -0.0000

## 420 0.0003 nan 0.1000 -0.0000

## 440 0.0002 nan 0.1000 -0.0000

## 460 0.0002 nan 0.1000 -0.0000

## 480 0.0001 nan 0.1000 -0.0000

## 500 0.0001 nan 0.1000 -0.0000

##

## Iter TrainDeviance ValidDeviance StepSize Improve

## 1 1.1294 nan 0.1000 0.0807

## 2 0.9995 nan 0.1000 0.0649

## 3 0.8940 nan 0.1000 0.0534

## 4 0.8063 nan 0.1000 0.0408

## 5 0.7357 nan 0.1000 0.0352

## 6 0.6718 nan 0.1000 0.0287

## 7 0.6156 nan 0.1000 0.0264

## 8 0.5677 nan 0.1000 0.0205

## 9 0.5260 nan 0.1000 0.0195

## 10 0.4880 nan 0.1000 0.0174

## 20 0.2582 nan 0.1000 0.0057

## 40 0.1010 nan 0.1000 0.0003

## 60 0.0557 nan 0.1000 -0.0007

## 80 0.0339 nan 0.1000 0.0002

## 100 0.0224 nan 0.1000 -0.0000

## 120 0.0156 nan 0.1000 -0.0002

## 140 0.0112 nan 0.1000 -0.0001

## 160 0.0088 nan 0.1000 -0.0001

## 180 0.0067 nan 0.1000 -0.0001

## 200 0.0052 nan 0.1000 -0.0001

## 220 0.0034 nan 0.1000 -0.0000